一、产品介绍

蚂蚁集团旗下inclusionAI团队近期开源了全球首个万亿参数级推理大模型Ring-1T-preview,标志着超大规模语言模型在自然语言推理(NLR, Natural Language Reasoning)领域取得重大突破。该模型基于Ling 2.0高效的混合专家(Mixture of Experts, MoE)架构构建,完成了20T tokens的超大规模预训练,并依托团队自主研发的高效强化学习系统ASystem,采用RLVR(Reinforcement Learning from Verifier Feedback)框架针对推理能力进行了深度优化。

其差异化技术亮点集中体现在纯自然语言推理能力上。与传统依赖工具调用或符号系统的模型不同,Ring-1T-preview专注于通过深度思考链(Chain-of-Thought)解决复杂抽象问题。在多项国际顶级学术竞赛中,其表现不仅验证了技术路线的可行性,更强化了“规模与精调并重”的模型发展理念。

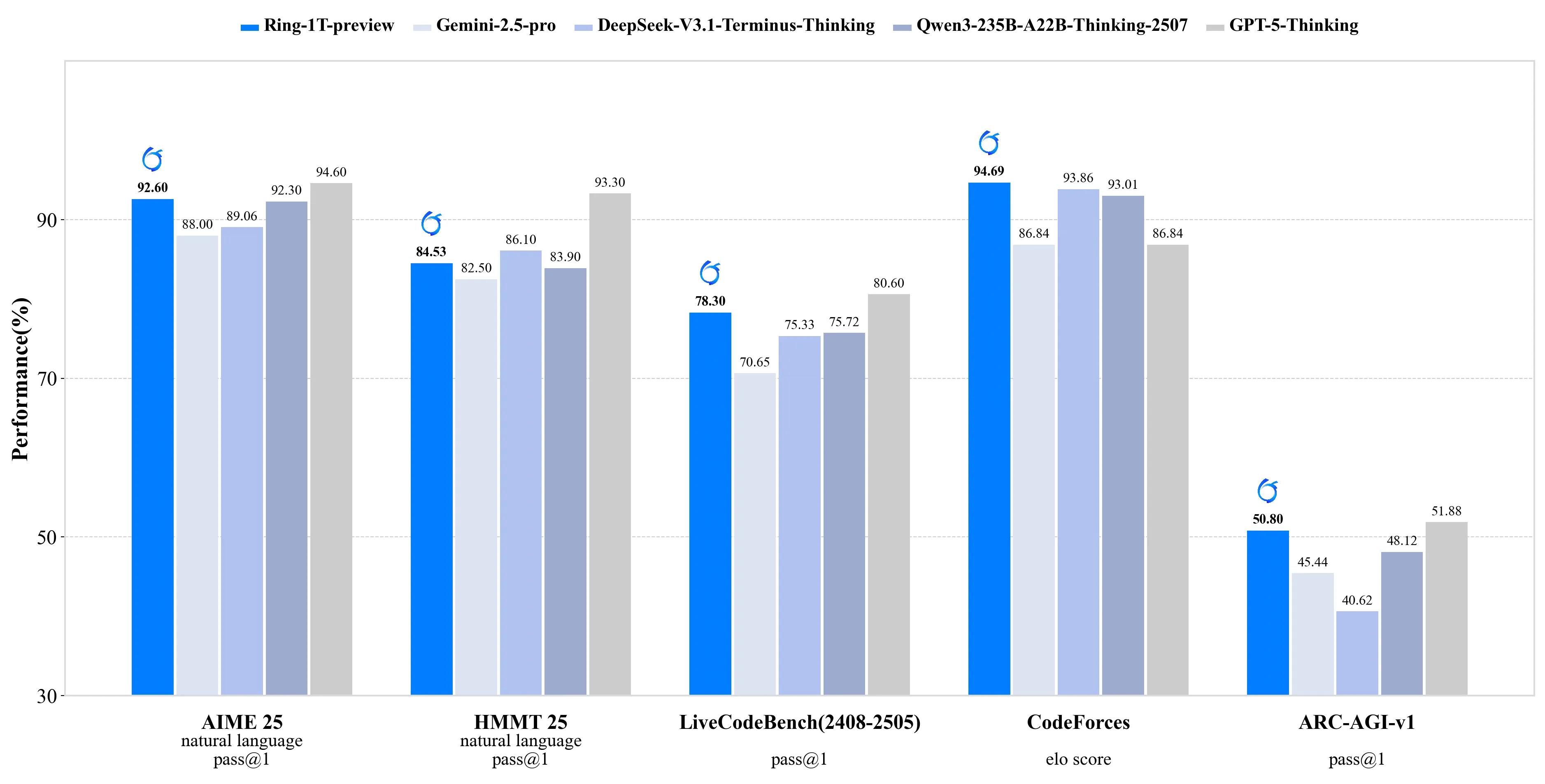

图:Ring-1T-preview与其他主流模型在数学推理基准上的性能对比示意图

二、技术讲解

Ring-1T-preview的技术栈围绕三大核心构建:高效架构、定向训练与验证反馈。

分布式MoE架构是模型实现万亿参数规模的基础。与稠密模型相比,MoE架构通过动态激活专家网络,在推理过程中显著降低计算开销,使训练和推理超大规模模型成为可能。Ring-1T-preview延续了Ling 2.0的架构设计,但在专家路由(Expert Routing)策略上进行了优化,提升了模型在处理逻辑密集型任务时的稳定性。

RLVR训练与icepop方法是模型获得卓越推理能力的关键。团队采用了此前披露的“icepop”训练方法,在ASystem系统中进行了大规模强化学习训练。该方法的核心在于利用验证器反馈引导模型生成过程,使模型学会自我验证推理步骤的有效性,从而减少幻觉和逻辑谬误。这种训练方式在面对IMO、AIME等需要严谨推导的任务时尤为有效,使模型能够进行更长的有效推理链生成。

多智能体测试框架进一步挖掘了模型潜力。团队将模型集成到多智能体框架AWorld中进行测试,模拟了协作与竞争并存的复杂推理环境。在IMO 2025的测试中,模型在单次尝试中解决了第3题,并对其他问题输出了部分正确解答,展现出在构造性证明、反例生成和策略性思维方面的能力。

三、实战使用

对于开发者而言,通过Transformers库快速调用Ring-1T-preview进行推理任务并不复杂。以下代码示例展示了如何使用ModelScope加载模型并生成回答:

from modelscope import AutoModelForCausalLM, AutoTokenizer

model_name = "inclusionAI/Ring-1T-preview"

model = AutoModelForCausalLM.from_pretrained(

model_name,

dtype="auto",

device_map="auto",

trust_remote_code=True,

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

prompt = "证明勾股定理:直角三角形两直角边的平方和等于斜边的平方。"

messages = [

{"role": "system", "content": "You are Ling, an assistant created by inclusionAI"},

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages, tokenize=False, add_generation_prompt=True

)

model_inputs = tokenizer([text], return_tensors="pt", return_token_type_ids=False).to(model.device)

generated_ids = model.generate(

**model_inputs,

max_new_tokens=8192 # 支持生成长推理文本

)

generated_ids = [output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

print(response)这段代码会引导模型生成一个关于勾股定理的逐步证明过程。实际测试中,模型能够输出包括几何构造和代数推导在内的完整证明步骤,展示了其逐步推理能力。

需要注意的是,当前预览版本仍存在一些局限性,例如偶现的语言混杂、重复推理或身份误认现象。建议用户在复杂应用场景中增加验证机制,或通过提示工程约束模型输出格式。

四、性能表现与社区反馈

根据官方披露的测试数据,Ring-1T-preview在多个权威基准上展现了强劲竞争力。在AIME 2025(美国邀请数学考试)中,模型通过纯自然语言推理获得了92.6分的高分,与GPT-5的94.6分相差无几。在LiveCodeBench v6、CodeForces等竞赛级别代码生成任务中,模型同样表现出色,证明了其推理能力在不同领域的可迁移性。

IMO 2025的测试结果尤为引人注目。在仅允许三次推理尝试的设置下,前代模型Ring-flash-2.0仅在最后一次尝试中解决了第3题,而Ring-1T在第一次尝试中就成功解决同一问题,同时还对第1、2、4和5题输出了部分正确解答。这种性能跃迁印证了万亿参数模型与专门化训练方法结合带来的突破。

社区早期测试反馈表明,模型在需要多步逻辑推理的任务上优势明显。某研究团队在抽象推理基准ARC-AGI-1任务上测试后表示,模型对复杂模式的理解能力超越同等参数规模的通用模型,任务处理效率提升约3倍。

五、访问地址

- 魔搭社区访问地址: https://modelscope.cn/models/inclusionAI/Ring-1T-preview/summary

- huggingface访问地址: https://huggingface.co/inclusionAI/Ring-1T-preview

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...