提到多模态大模型,很多人会默认“参数越大性能越强”,但Ovis2.5偏要打破这个固有印象——它用更小的参数规模,交出了碾压级的成绩单。

这次Ovis2.5推出的9B和2B两个版本,在权威评测OpenCompass里分别拿到78.3分和73.9分,直接把开源模型的纪录给刷新了。其中9B版本在40B以下参数的模型里稳坐第一,更意外的是2B版本,性能居然超过了不少7B参数的模型。最让人惊喜的还要数数学推理能力:在MathVista测试中,9B版本拿下83.4分,不仅超过Gemini Pro的80.9分,就连GPT-4o的71.6分都被甩在了后面;2B版本也不甘示弱,以81.4分轻松碾压同级别模型。

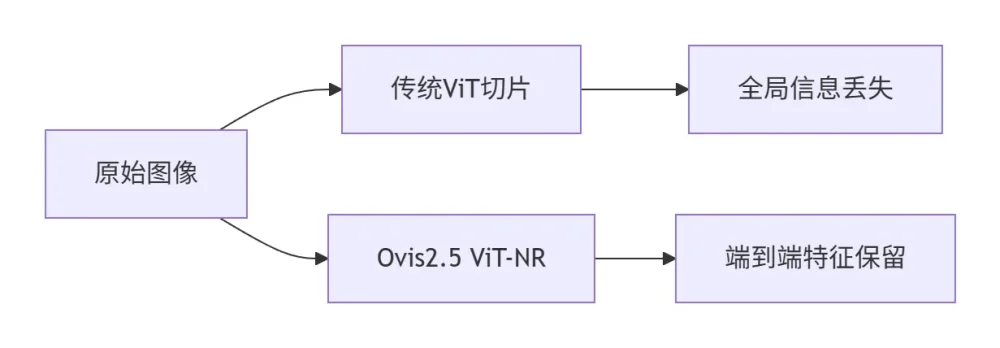

为啥小参数能有这么强的实力?核心秘密藏在它的动态分辨率视觉编码器(NaViT)里。以前的模型处理高分辨率图像,总得把图切成小块,结果要么图表的整体结构被拆得七零八落,要么文字细节直接丢失。但Ovis2.5的NaViT不一样,它能直接处理原生分辨率图像,最高支持1792×1792像素,还在ViT层里嵌了旋转位置编码(RoPE)——这样一来,图像的宏观布局和微观细节能同时抓得稳稳的。实测数据也很能说明问题:物流单据的OCR识别准确率提升了12%,发票密文提取的错误率更是直接降了37%。

用AI解题时,你是不是也碰到过这种糟心情况:模型跳步跳得厉害,最后得出的答案还特别离谱?Ovis2.5针对这个问题,专门搞了个“反思式推理链”,相当于给模型加了个可开关的“思考模式”。

在训练阶段,它通过DPO偏好对齐和GRPO强化学习,自己合成了10万组带自我修正步骤的“思考数据”;到了实际推理时,用户想让模型更严谨,就手动打开“思考模式”——这时候模型会主动把中间推导过程写出来,检查逻辑漏洞,甚至修正之前的错误结论。这种设计很灵活,既能保证精度,又能控制延迟:默认模式下,模型直接输出答案,响应更快;打开“思考模式”后,高中数学图像题的解题准确率从68%涨到了79%,不过推理耗时会增加40%。比如解三角函数图像题时,它不会像以前那样“看图蒙答案”,而是先标注周期、振幅,再验算公式匹配度,最后才输出结果,大大减少了“幻觉”问题。

图表理解一直是多模态领域的“老大难”——要么噪声元素干扰识别,要么数据密度太高理不清,再加上逻辑链藏得深,之前的模型大多束手无策。Ovis2.5从三个维度一起发力,才算把这个“死穴”打通了。

首先是数据层,它新增了50%的高质量数据,涵盖图表、OCR、Grounding三大类,还覆盖了财报、物流单、科学图谱等20种复杂场景,让模型见的“世面”更广;然后是视觉层,靠NaViT直接解析图表元素,不会像以前那样因为切图,导致坐标轴断裂、图例错位;最后是推理层,融合了之前的反思机制,让模型能分清主辅数据——比如分析美国服务业就业图表时,它会先定位坐标单位,再排除灰色背景这种噪声,最后精准锁定教育板块的占比数据。

这样的优化效果很明显:在ChartQA Pro测试中,Ovis2.5-9B拿到63.8分,不仅创了开源模型的新高,还比前代提升了17.2%;中文OCR任务(OCRBench-CN)里,它更是拿到58.0分,把GPT-4o的32.2分远远甩在了后面。

Ovis2.5能有这么大的性能飞跃,背后其实是训练范式的彻底重构——它用了五阶段渐进式训练,每一步都踩得很实:

- 视觉预训练:先把ViT的大部分参数冻结,再用图像-文本对训练视觉嵌入表(VET),打好视觉基础;

- 多模态对齐:激活RoPE位置编码,把OCR、定位数据“灌”进模型,让视觉和语言能力衔接更顺畅;

- 指令微调:引入多图像、视频,还有带反思标签的QA数据,让模型更懂实际任务需求;

- DPO对齐:对所有参数做优化,同时结合负对数似然损失,减少模型“瞎编”的情况;

- GRPO强化:冻结视觉模块,专心调优语言模型的推理能力,避免顾此失彼。

这套训练方法还大大提升了效率:通过多模态数据打包减少填充计算,再加上数据、张量、上下文混合并行的框架降低内存占用,训练效率直接提升了3-4倍。以前端到端训练要21天,现在6天就能完成——这也让中小团队复现模型变成了可能。

现在Ovis2.5已经在阿里国际的跨境电商场景里规模化落地了,实际用起来效果怎么样?咱们看几个具体例子就知道:

- 物流分拣:直接识别面单照片,输出包含运费、追踪号、收发地址的JSON格式数据,测试时处理速度能到2000单/分钟,错误率还不到0.3%;

- 数学教育:输入函数图像,不仅能自动解题,还会生成完整推导步骤,从高中题型到大学微积分都能覆盖;

- 文化理解:识别西湖风景照后,能自动关联“接天莲叶无穷碧”这类古诗,文化语义的准确率达到91%;

- 退货审核:分析用户上传的商品损坏视频,一秒钟就能判定责任方,现在已经能替代30%的人工审核岗位。

目前阿里国际AI的日调用量已经超过10亿次,每两个月就翻一番;有50万跨境商家在用Ovis2.5优化商品标题、做虚拟试衣,或是搞多语言营销——实实在在帮商家降本增效。

Ovis2.5的2B版本还专门为端侧设备做了优化,主打轻量化部署。比如在英伟达Jetson Orin开发板上测试时,把模型量化到INT4之后,只需要4GB显存,响应延迟还不到1.5秒,完全能支持工业摄像头实时做OCR分析。

现在它的代码和模型已经在GitHub、HuggingFace上开源了,用的还是商用友好协议——开发者拿过去就能快速集成到物流机器人、智能显微镜这些终端设备里,不用再为“能不能商用”纠结。

? 立即体验

在线Demo:

https://huggingface.co/spaces/aidc-ai/ovis2.5-9b

https://huggingface.co/spaces/aidc-ai/ovis2.5-2b

技术报告:https://arxiv.org/abs/2508.11737

不过Ovis2.5的进化还没到终点。从技术报告里能看出来,4K高分辨率感知、长视频时序推理、工具调用架构这些功能已经在研发中了。现在很多厂商都在盯着千亿参数的大模型“较劲”,但阿里国际选了另一条路——他们想让小模型也能看懂真实世界里的复杂逻辑,而Ovis2.5,就是这条路上的重要一步。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...