一、产品介绍

划时代突破的幕后主角:

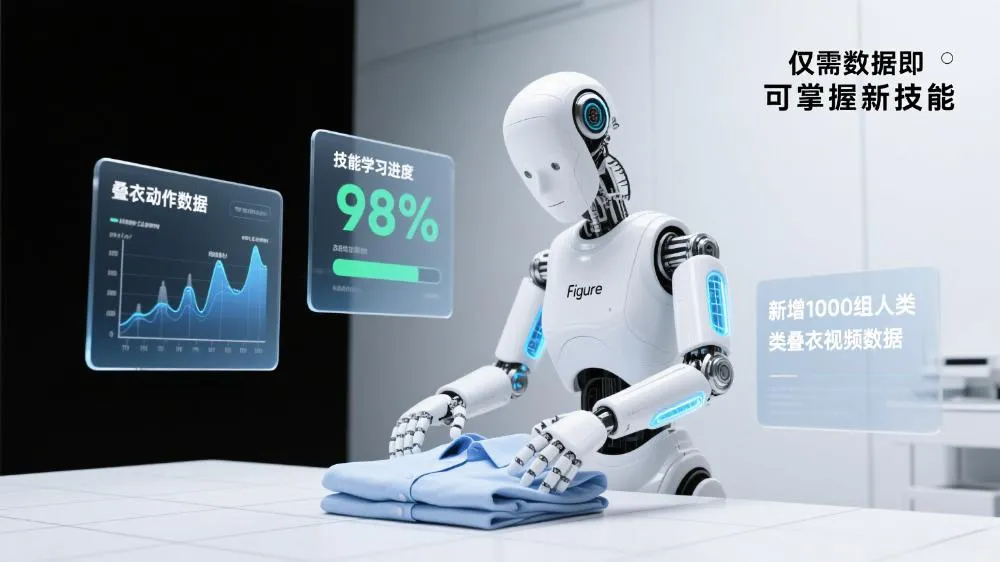

创立于2022年的Figure AI,堪称机器人界的“硅谷黑马”。背靠微软、英伟达、OpenAI等巨头投资,估值飙升至369亿美元(2025年数据)。其旗舰产品Figure 02人形机器人身高180cm,配备33自由度灵巧手,尤其五指结构可实现人类级精细操作。最新发布的叠衣演示中,机器人通过纯视觉感知完成毛巾抓取、抚平褶皱、折叠收纳等全流程,动作流畅度震惊业界!

二、适用人群

这项技术革新将直接赋能三类群体:

✅ 工业场景开发者:物流分拣、柔性产线操作员

✅ 家庭服务机器人厂商:解决衣物整理、家务协助等痛点

✅ 具身智能研究者:探索通用机器人学习范式的实验室

三、核心功能

Table: Helix架构核心能力与技术实现

| 功能 | 技术实现原理 | 应用场景 |

|---|---|---|

| 多模态交互 | S2系统解析语言指令+视觉输入,生成语义向量 | 人类指令实时响应 |

| 动态物体操控 | 端到端神经网络映射像素→动作,实时调整抓握力 | 折叠可变性衣物 |

| 错误自主修复 | 力反馈传感器闭环控制,检测抓取异常并回溯 | 多抓物品自动放回 |

| 跨场景技能迁移 | 统一模型权重适配不同任务,仅需新增数据集 | 物流→家务无缝切换 |

| 人类风格动作模仿 | SMPL-X模型重定向人体运动数据至机器人关节 | 拟人化手势与眼神 |

? 关键技术细节:

- 抗干扰操作:误抓多余毛巾时,力反馈触发自修正机制,放回冗余物品后继续折叠

- 零预设动作库:拇指描边、捏角防滑等动作均由神经网络动态生成

四、技术原理:暴力美学的三层架构

1️⃣ 双系统协同框架(S2+S1)

- S2慢思考层:7B参数视觉语言模型,9Hz频率解析环境语义(例:识别“折叠毛巾”指令)

- S1快执行层:200Hz高频Transformer,将语义向量转为关节控制信号

“这种解耦设计让机器人既能深谋远虑,又能闪电反应” —— Figure AI技术白皮书

2️⃣ 端到端感知控制闭环

graph LR

A[双目RGB摄像头] --> B(像素数据)

B --> C{Helix神经网络}

C --> D[手腕关节角度/手指屈曲指令]

D --> E[PD控制器扭矩转换]

E --> F[33自由度动作输出]关键突破:跳过传统“物体建模-路径规划”流程,直接实现像素→动作的极简映射

3️⃣ 数据驱动的泛化能力

- 训练逻辑:500小时基础操作数据 + 40小时叠衣专项数据

- 领域随机化:模拟环境中随机化布料摩擦力、形态参数,提升现实鲁棒性

五、工具使用技巧

想最大化发挥Helix潜力?试试这三招:

✨ 数据采集捷径:

用人类动作捕捉系统(如SMPL-X)录制示范视频,经重定向算法快速生成训练集

✨ 故障规避策略:

在光照复杂场景中,为摄像头加装偏振滤镜,减少反光对布料识别的干扰

✨ 技能加速迭代:

采用“模拟器预训练+现实微调”模式:

- MuJoCo中构建可变毛巾模型

- 域随机化生成万组训练场景

- 真实世界10小时适配量产

六、访问地址

? 官方资源一键直达:

- 技术白皮书:https://www.figure.ai/news/helix-learns-to-fold-laundry

- 叠衣演示视频:https://x.com/adcock_brett/status/1955291307758489909

- 开发者API文档:https://github.com/Figure-AI

行业启示:宇树科技王兴兴指出:“当硬件趋于成熟,数据效率将成为下一个竞争壁垒”。这场由Figure掀起的“数据暴力革命”,正在重新定义机器人的进化规则!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...