? 产品介绍

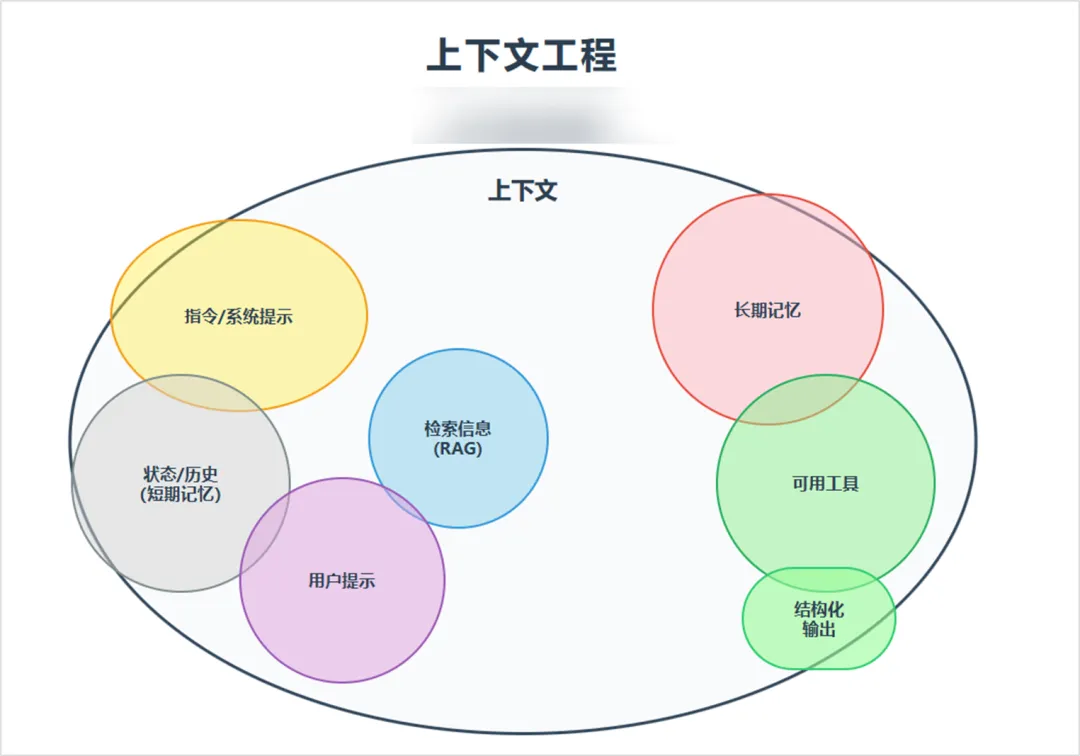

上下文工程(Context Engineering) 是由OpenAI、LangChain等机构推动的新一代AI系统设计范式,被Karpathy称为“氛围编程”。它通过动态构建任务所需的完整信息生态——包括历史对话、工具接口、实时数据和记忆系统——让大模型摆脱“盲人摸象”困境,将AI智能体成功率提升300%。2025年被硅谷视为“AI智能体元年”,而上下文工程正是智能体落地的核心基础设施。

? 适用人群

- AI应用开发者:解决复杂任务中LLM的“记忆丢失”和工具调用失败问题

- 产品经理:设计更自然的用户-AI交互流程,降低人工干预需求

- 企业技术负责人:搭建高可靠AI客服、数据分析助手等生产级系统

- AI研究者:探索多模态信息融合与认知架构设计新方向

⚙️ 核心功能与技术实现

| 功能模块 | 技术原理 | 解决痛点 |

|---|---|---|

| 动态上下文组装 | 实时注入用户输入+历史摘要+工具返回数据 | 避免重复提问和信息碎片化 |

| 记忆压缩系统 | 向量化存储对话关键点,Token占用降低70% | 突破上下文窗口限制 |

| 工具链路由 | 函数描述结构化(JSON Schema)+ 自动触发机制 | 解决“有工具不会用”问题 |

| 多源检索增强 | 融合长期记忆(用户偏好)+短期记忆(当前会话)+RAG实时数据 | 消除信息孤岛 |

| 响应格式化 | 输出模板引擎(例:自动生成带标题的分段报告) | 确保结果直接可用 |

? 典型案例:当用户问“明天能开会吗?”,系统自动注入:

1️⃣ 日历工具返回的今日排程

2️⃣ 历史邮件中该用户的优先级标签

3️⃣ 会议室预订API接口描述

→ 生成响应:“周四上午10点有空,已预留A会议室,需要现在发邀请吗?”

?️ 工具使用技巧(附实操代码)

▶️ 三步构建高效上下文

# 示例:基于LangChain的上下文组装引擎

from langchain_core.prompts import ChatPromptTemplate

from langchain_community.tools import Tool

# 1. 定义动态上下文源(关键!)

context_sources = {

"calendar": Tool.from_function(get_calendar_events),

"user_profile": Tool.from_function(fetch_user_prefs),

"project_docs": Tool.from_function(retrieve_rag_docs)

}

# 2. 创建提示模板(含结构化占位符)

prompt = ChatPromptTemplate.from_messages([

("system", "你正在处理{user_name}的任务,当前时间:{current_time}"),

("placeholder", "{agent_scratchpad}"), # 留白区自动填充工具返回

("human", "{input}")

])

# 3. 绑定实时数据流(自动触发工具调用)

agent = create_react_agent(llm, tools, prompt)✨ 高效实践心法

信息密度控制

用摘要替代原始数据:将50页PDF浓缩为3条核心结论再注入上下文

❌ 错误示范:直接塞入完整API文档 → ✅ 正确做法:预生成工具使用示例优先级分层策略

[必加载层] 工具定义 + 用户当前指令 [按需加载层] 相关历史摘要(最近3次对话) [延迟加载层] RAG检索结果(仅当模型请求时触发)减少幻觉黑科技

在系统提示中声明:“所有结论必须基于{{context}}中的证据”

添加自检链(Auto Verification):要求模型标注信息溯源位置

? 访问地址

▶️ LangChain上下文工程指南:https://blog.langchain.com/the-rise-of-context-engineering/

▶️ OpenAI智能体开发框架:https://platform.openai.com/docs/assistants/overview

与其苦苦调试提示词,不如让AI自己“看清全局”。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...