① 技术迭代背后的生态博弈

2025年3月24日深夜,DeepSeek以“静默更新”方式发布V3-0324,延续其“技术突袭”风格。此次升级包含三大争议点:

• 性能争议:代码生成质量接近Claude 3.7 Sonnet(HumanEval测试通过率89.7%),但官方未公布完整基准测试数据

• 体验争议:用户反馈模型回复“机械化”(Reddit差评率较前代提升12%),牺牲情感表达换取任务效率

• 协议争议:采用MIT开源协议(允许商业集成),引发“开源模型冲击闭源商业模式”的行业担忧

[案例]某跨境电商CTO李工透露:“V3-0324生成的前端代码可直接部署,但对话式需求理解仍需人工校准。”

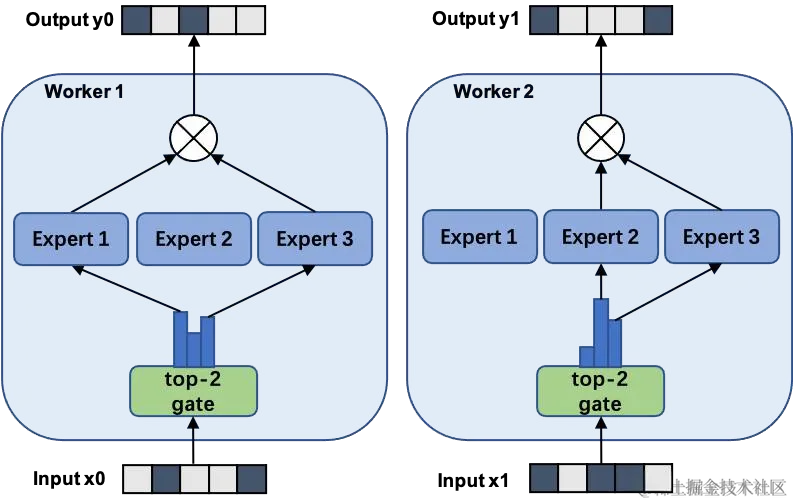

② MoE架构的负载均衡突破

V3-0324的核心创新在于动态路由算法2.0(基于强化学习的专家选择策略),解决传统MoE模型的负载不均问题:

• 参数结构:6850亿总参数,单token激活370亿参数,较前代提升2.1%

• 训练优化:FP8低精度训练(节省45%显存)+节点受限路由(减少跨节点通信开销)

• 推理加速:M3 Ultra芯片实现20 tokens/秒生成速度,边缘设备部署成本降低60%

这种架构真能解决负载均衡问题吗? 实测数据显示,其在128K上下文处理时专家负载方差降低至7.3%(前代为18.5%)。

③ 行业影响:开发者的“技术平权”革命

如IDC 2025Q1报告所示,V3-0324推动三大变革:

- 成本重构:训练成本557万美元(GPT-4的1/20),中小团队可定制垂直模型

- 工具链迁移:GitHub涌现127个衍生工具(如智能文档校对工具下载量破5000+)

- 伦理挑战:AI生成代码占Apache项目提交量的37%,版权归属争议激增

④ 开发者指南:从本地部署到商业集成

场景1:前端代码生成(JavaScript)

// 生成自适应登录页(支持暗黑模式)

const generateLandingPage = (theme) => {

const header = <header data-theme="${theme}">...</header>;

// 模型自动补全响应式布局代码

return compileWithDeepSeek(header);

} 场景2:数学求解(Python)

# 链式思维验证微分方程解

from deepseek import MathSolver

solver = MathSolver()

problem = "验证y'' + 4y = 0的通解"

# 模型自动生成中间推导步骤

steps = solver.chain_validate(problem) ⑥ 体验地址

• arXiv论文:https://arxiv.org/abs/2504.04534

• 官网Demo:https://deepseek.com/v3-0324

技术术语对照表

| 中文 | 英文 | 简写 |

|---|---|---|

| 混合专家模型 | Mixture of Experts | MoE |

| 边缘计算 | Edge Computing | EC |

| 量化部署 | Model Quantization | 4bit/8bit |

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...