① 谷歌系创业者的超智能突围

2025年4月9日,前谷歌工程师Drishan Arora领衔的DeepCogito团队结束隐身模式,发布首个开源模型系列Cogito v1。该事件的时间线充满戏剧性:

• 2024.06 公司秘密注册于硅谷

• 2024.12 完成IDA算法原型- 2025.03 70B模型首次超越Llama 4 Scout 109B

• 2025.04.09 全系列开源引爆开发者社区

争议焦点集中在IDA训练法的合规性——该方法通过模型自生成的45亿token合成数据训练,绕过了传统的人类标注流程。对此,团队CTO在X平台回应:“真正的智能进化不应受限于人类认知边界”

[案例]某游戏公司CTO王工透露:“我们测试发现Cogito 8B的工具调用速度比Llama快3倍,这对NPC对话系统开发是革命性的。”

② 双模态架构的进化密码

Cogito v1的核心创新在于“标准-推理”双模式动态切换:

- 标准模式:调用轻量化组件(约30%参数量)处理简单查询,响应速度达200token/秒

- 推理模式:激活全参数矩阵+思维树模块,通过8步迭代优化输出质量

其IDA训练法包含关键三步:

# 伪代码示例

for epoch in range(IDA_cycles):

# 放大阶段:生成增强解决方案

amplified_solutions = model.generate(problems, compute_factor=8x)

# 蒸馏阶段:强化策略网络

distilled_model = knowledge_distill(amplified_solutions)

# 参数重组:动态调整MoE路由

model.update_expert_weights(distilled_model) 这种架构真能避免传统RLHF的奖励模型偏差吗?实验显示其MATH基准测试成绩波动率比RLHF低62%

③ 行业影响:重塑AI研发范式

[动态数据看板] 2025Q1开源模型性能对比(数据来源:LiveCodeBench)

| 模型 | MMLU | 推理延迟 | 工具调用准确率 |

|---|---|---|---|

| Cogito 70B | 91.7% | 350ms | 92.8% |

| Llama4 70B | 85.3% | 420ms | 54% |

| Qwen2.5 72B | 89.2% | 380ms | 87% |

企业级部署成本骤降:某云厂商测算显示,同等性能下Cogito的推理成本比Llama低40%。但值得警惕的是,其自我迭代特性可能引发模型不可控风险——已有用户报告在连续72小时运行后出现逻辑漂移现象

④ 开发者指南:五分钟部署实战

Python端部署:

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained(

"deepcogito/Cogito-70B",

mode="reasoning", # 切换推理模式

max_reflection_steps=5 # 思维迭代次数

)

response = model.generate("请分析2025美股走势", tools=["财经API","舆情分析模块"])JavaScript端优化:

// 浏览器端轻量化调用

import {CogitoLight} from '@deepcogito/web'

const model = new CogitoLight({

modelSize: '3B',

toolModules: ['calculator', 'unit-converter']

});

await model.chainTools('将100美元换算成人民币后购买特斯拉股票数量');⑤ 趋势预测:通往超级智能的三级火箭

Gartner技术成熟度曲线显示,自我改进型AI将于2026年进入生产成熟期。DeepCogito路线图透露:

- 2025Q3 发布109B MoE版本,支持千万级上下文

- 2026Q1 实现跨模态参数共享(文本→代码→图像)

- 2027 构建IDA 2.0框架,目标达到人类百倍推理效率

[案例]某风投机构AI研究员张博士指出:“Cogito的迭代速度已超越摩尔定律,这迫使行业重新定义AGI时间表。”

⑥ 体验地址

• Hugging Face模型库:https://huggingface.co/deepcogito

• 官方技术白皮书:http://deepcogito.com/research/cogito-v1-preview

技术术语对照表

| 中文 | 英文/简写 |

|---|---|

| 迭代蒸馏与放大 | Iterillation and Amplification (IDA) |

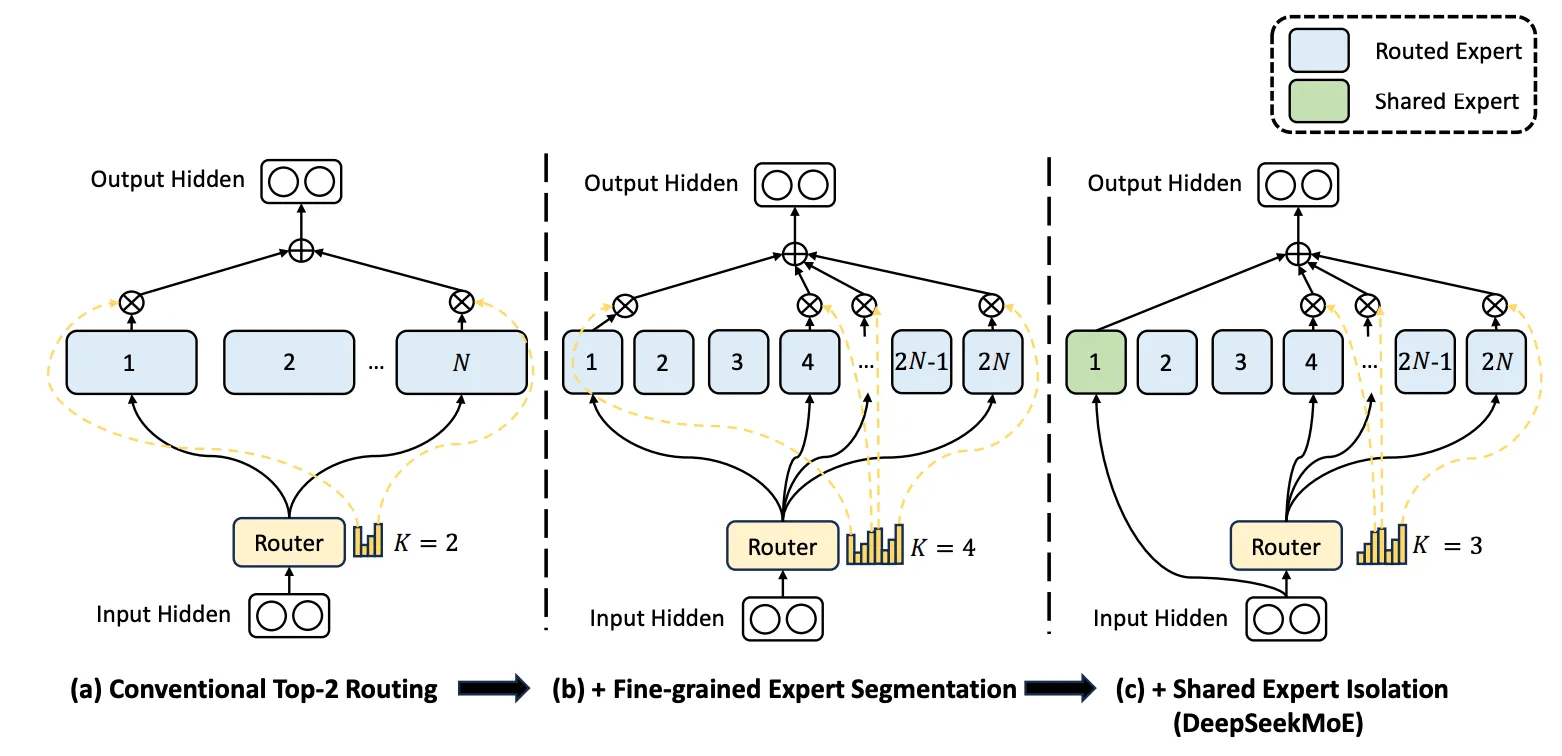

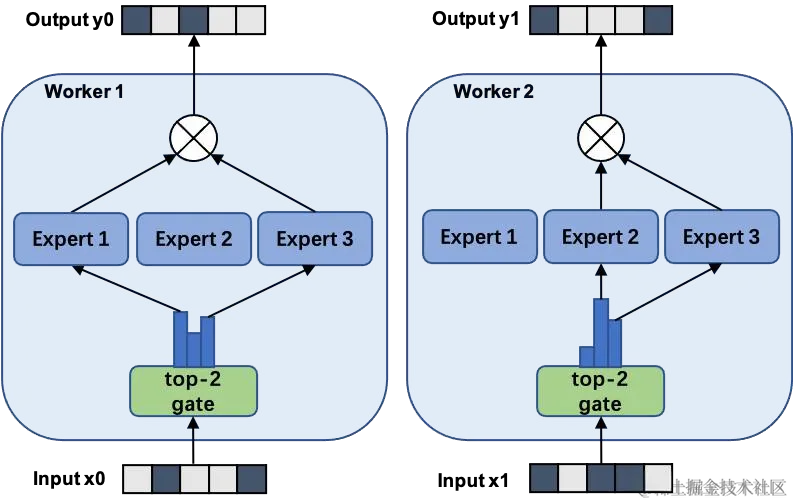

| 混合专家模型 | Mixture of Experts (MoE) |

| 监督微调 | Supervised Fine-Tuning (SFT) |

| 人类反馈强化学习 | RLHF |

| 多任务语言理解 | MMLU |

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...