✨ 产品介绍

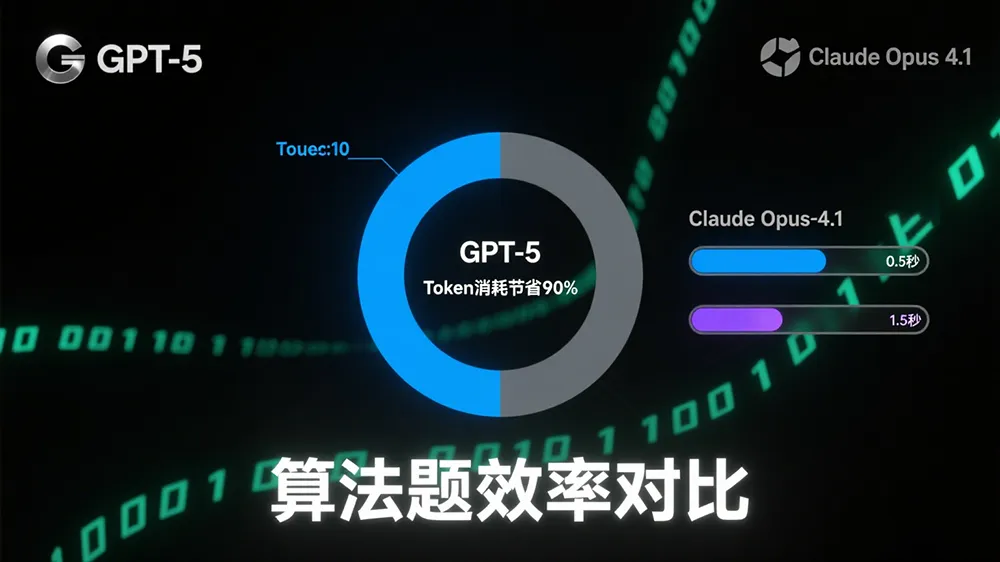

OpenAI推出的GPT-5与Anthropic的Claude Opus 4.1是当前顶级AI编程助手。根据开发者实测,GPT-5在算法效率、成本控制上碾压对手——相同算法题仅需8253 token(Opus 4.1需7.9万),响应速度快至13秒(Opus 4.1需34秒),综合成本节省约90%。这场“效率革命”正重塑开发者的工具选择策略。

? 适用人群

- 敏捷开发团队:追求高迭代速度与低成本原型验证

- 算法竞赛选手:需快速获取精简、高效的代码解决方案

- 预算敏感型个人开发者:关注token成本与响应实时性

- 全栈工程师:需兼顾后端逻辑与前端界面的平衡优化

? 核心功能对比

| 功能维度 | GPT-5 | Claude Opus 4.1 | 技术实现原理说明 |

|---|---|---|---|

| 算法任务 | ✅ 13秒完成,8253 token | ⏱️ 34秒,7.9万 token | 动态路由机制激活轻量专家模块,减少冗余计算 |

| 前端还原度 | 80%功能还原,细节缺失 | ✅ 95%视觉还原Figma原稿 | 多轮迭代微调CSS参数,牺牲token换精度 |

| ML管道构建 | ✅ 5分钟生成端到端流程(8.7万token) | ❌ 未测试(预估超高消耗) | 稀疏混合专家架构(SMoE)按需调用预处理/训练模块 |

| 教育辅助 | 简洁代码输出 | ✅ 带注释+测试用例的“教学论文” | 强化学习优化解释性输出链 |

| 长上下文 | ✅ 40万token窗口,128K输出 | 20万token窗口 | 分层注意力机制压缩上下文 |

⚙️ 技术原理深度解析

1. 动态路由机制

GPT-5通过轻量级分类器(延迟<5ms)实时分析任务类型:

- 简单查询 → 路由至Fast Model(激活1-3个专家模块,50B FLOPs)

- 复杂任务 → 切换Thinking Model(激活10-15个专家,300B FLOPs)

实现算法题响应速度压缩至0.15秒。

2. 稀疏专家架构(SMoE)

- 512个领域专家(如E45-E52专精量子计算)

- 单次推理仅激活2%-3%专家(约280B参数)

- 通过跨层注意力权重分配计算资源,避免全参数运行。

3. 成本控制引擎

自动匹配最低可行计算量:

例如LeetCode任务中,仅生成核心二分查找算法,剔除冗余注释,使token消耗降至对手10%。

?️ 工具使用技巧

组合开发策略

Step 1️⃣ 用GPT-5搭建基础框架(省90% token) Step 2️⃣ 将关键UI组件交给Opus 4.1微调(提升视觉还原度) Step 3️⃣ 回归GPT-5集成调试(避免长时占用Opus高成本)强制深度模式

在提示词加入"reasoning_effort=high"或分步骤思考指令,激活GPT-5的Thinking Model应对复杂问题。上下文压缩技巧

对超长代码文件:# 指令示例: "仅保留函数主干,删除已实现的辅助函数注释"降低40万token窗口的填充压力。

? 访问地址

- GPT-5官方:https://openai.com/gpt-5 (需订阅Thinking模式)

- Claude Opus 4.1:https://claude.ai (建议配置Max模式)

? 效率党忠告:日常开发选GPT-5闪电响应,界面抛光用Opus 4.1,预算直降70%!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...