? 产品介绍

Runway AI —— 这家纽约起家的AI视频初创公司,正以Gen-4世界一致性模型掀起好莱坞技术海啸。2025年估值突破30亿美元的背后,是奈飞在《永航员》中实现建筑坍塌场景10倍速制作、迪士尼秘密测试特效工具的商业认可。不同于通用视频工具,Runway专为影视工业化设计的解决方案,已渗透至剧本可视化、动态捕捉、场景重建全流程。

? 适用人群

| 群体类型 | 典型应用场景 |

|---|---|

| 流媒体平台 | 奈飞式高密度内容生产的特效优化 |

| 电影工作室 | 低成本实现灾难场景/历史重建 |

| 独立创作者 | 单人完成电影级特效镜头 |

| 动画团队 | 替代传统动作捕捉系统 |

| 广告公司 | 秒级生成产品演示视频 |

⚙️ 核心功能与技术解析

1. 世界一致性建模(Gen-4核心突破)

技术原理:通过跨场景语义锁定算法,将角色/物体的视觉特征编码为128维向量。结合时间卷积网络(TCN) 实现帧间运动连贯性,彻底解决传统AI视频的“角色闪烁”痛点。

影视价值:奈飞《永航员》中坍塌建筑碎片的物理轨迹一致性,正源于此技术。

2. 物理特效生成(GVFX系统)

技术原理:基于条件生成对抗网络(cGANs),输入文本描述自动解构为物理参数(重力系数/材质密度/流体变量),实现真实光影反射与运动轨迹模拟。

效率对比:传统需2个月制作的建筑倒塌镜头,现3天完成且成本降90%。

3. 动态捕捉替代(Act-Two模型)

技术原理:通过运动向量插值技术,将真人动作视频映射至动画角色骨骼,取代笨重动捕设备。

案例:Runway演示片《The Lonely Little Flame》中臭鼬的拟人化行走,仅需2个路径标记点完成控制。

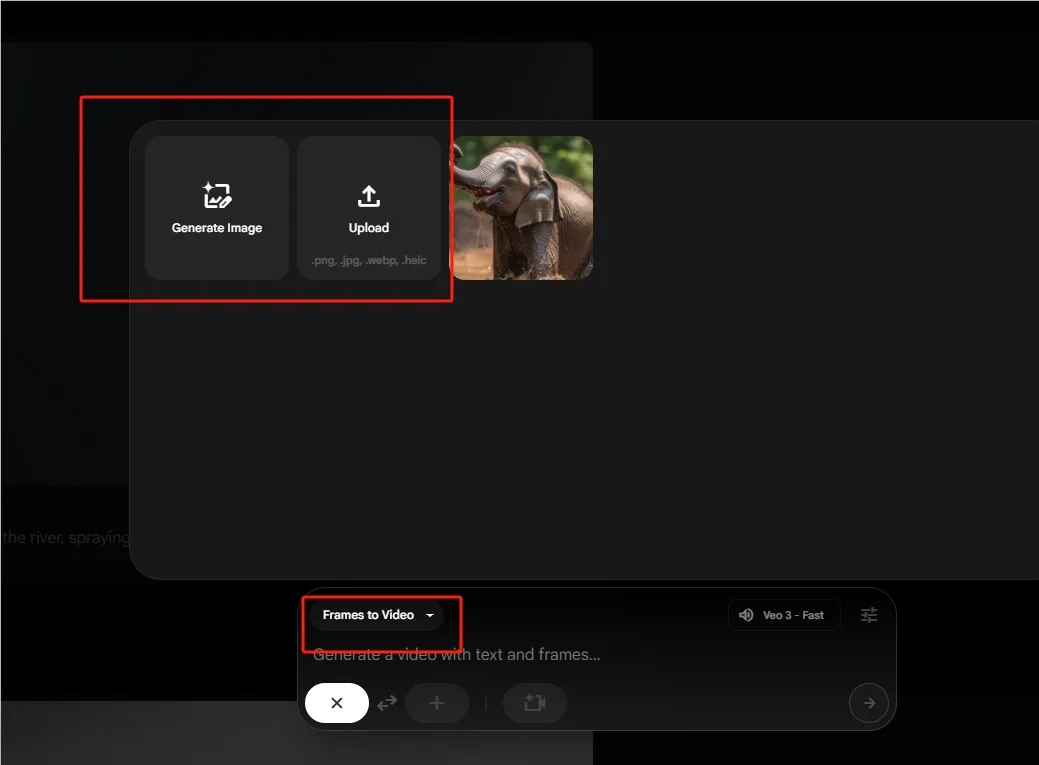

4. **多模态输入支持

技术原理:CLIP-ViT双编码器架构实现文本/图像特征融合,支持“概念画稿+文字描述”生成风格统一视频。

革新场景:导演可用分镜草图直接生成预演片段。

5. **老片修复增强

技术原理:应用时空感知超分模型,对低清影片进行分辨率重建与动态补偿,AI自动修复划痕/噪点/穿帮镜头(如威亚线智能擦除)。

实战成绩:香港老片修复效率提升400%。

? 工具使用技巧

⚡️ 效率跃迁三法则

- 关键词工程:提示词需包含物理参数(如“混凝土建筑坍塌 碎片飞溅速度>5m/s 扬尘浓度70%”)比艺术描述效率提升50%

- 分镜预演:用参考图+运动向量指令控制镜头语言:

[全景镜头 dolly left→特写镜头 zoom in 2x] [角色表情:焦虑→惊恐 过渡时间0.5s] - 素材循环:对AI生成片段标记时空锚点,便于后续调用相同场景元素

? 减淡“AI味”秘籍

- 缺陷修补:用AI生成基础素材,手动添加20%手绘细节(如面部微表情/布料褶皱)

- 混合拍摄:实拍前景+AI背景分层合成(《武状元苏乞儿》修复版采用此法)

- 胶片粒子:叠加35mm胶片颗粒纹理,中和数字感

? 访问地址

Runway官方平台:

? https://runwayml.com

注:企业用户需联系获取影视专用API接口

? 技术终究是画笔而非画家。当《永航员》的阿根廷团队用AI重现家乡废墟时,技术总监的感言值得玩味:“我们教会AI如何哭泣,但它始终不懂眼泪的温度”。这场变革的终局,或许藏在人类与算法共创的灰色地带里。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...