英伟达于2025年正式推出全球首个推理算力订阅服务Cloud AI Pass,基于其DGX Cloud Lepton平台与TensorRT-LLM核心技术,为企业提供免硬件改造的云端AI推理加速方案。该服务通过动态资源调度与全栈优化技术,显著降低大模型部署门槛,助力企业实现高吞吐、低延迟的AI应用落地。

产品核心解读

公司:英伟达(NVIDIA)

定位:全球首款推理算力订阅式服务,整合其收购的Lepton AI多云调度技术与自研AI加速栈,重构企业AI基础设施范式。

区别于传统云服务,Cloud AI Pass采用三层架构:

- 硬件层:欧洲20+座"AI工厂"数据中心提供H100/H200集群

- 调度层:Lepton专利技术实现99.9% GPU可用性

- 加速层:TensorRT-LLM优化推理全流程

突破性价值:企业无需替换现有服务器或购买专用卡,通过API接入即获得尖端推理算力。

适用人群精准匹配

| 用户类型 | 典型场景 | 核心获益点 |

|---|---|---|

| AI初创团队 | 大模型API快速部署 | 零硬件成本启动推理服务 |

| 传统企业IT部门 | 现有业务系统集成AI能力 | 免改造现有服务器架构 |

| 电商/金融平台 | 实时推荐与风控系统 | 20%响应速度提升 |

| 科研机构 | 多模态实验环境搭建 | 按需调用百亿级大模型 |

注:尤其适合需要高频调用AI服务但预算有限的团队,最低1GPU/小时起订。

五大核心功能解析

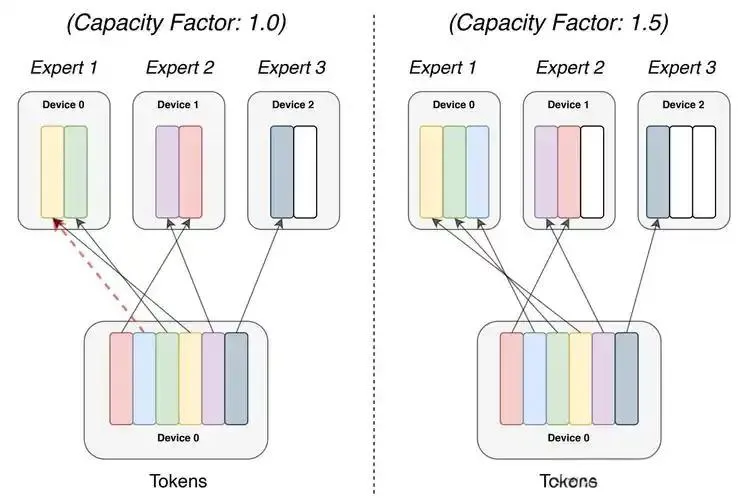

1. 动态算力切片技术

- 原理:通过神龙多租架构(空间维度多租混布+时间维度超卖复用)

- 效果:单张H100可切分为4个1/4卡实例,利用率提升300%

- 场景:应对突发流量波动,秒级弹性扩容

2. TensorRT-LLM加速引擎

- 原理:算子融合(Kernel Fusion)+ 显存带宽优化(KV Cache压缩)

- 效果:Decoder阶段延迟降低80%,token生成速度提升3倍

- 案例:Perplexity AI实现单位token成本下降60%

3. 多云无感调度

- 原理:Lepton自研抽象层对接AWS/Azure/Google Cloud GPU资源池

- 效果:跨云调度延迟<5ms,部署成本降低80%

- 突破:破解厂商锁定风险

4. 预置模型市场

- 亮点:提供Llama 3、DeepSeek-R1等50+预优化模型

- 技术:NVIDIA NIM微服务封装标准化接口

- 部署:HuggingFace模型一键迁移(<5分钟)

5. 能效优化系统

- 机制:动态电压频率调整(DVFS)+ 闲时实例冻结

- 数据:推理任务能耗降低30%,碳排减少45%

- 实测:10亿请求节省电费超$120,000

实战技巧三板斧

▋ 技巧1:混合精度加速法

- 操作:在NIM配置中启用FP8精度模式

- 收益:吞吐量提升2.1倍,显存占用减少50%

- 注意:需在模型head层保留FP16防精度损失

▋ 技巧2:冷热请求分离

- 场景:客服机器人高峰时段

- 方案:

if request.latency_sensitivity > 0.9: route_to_reserved_node() # 热路径保障<100ms else: route_to_elastic_pool() # 冷路径节省40%成本

▋ 技巧3:批处理黄金值

- 调优公式:

batch_size = (GPU显存-2GB)/单样本峰值显存 - 案例:DeepSeek-R1在4090卡上最优batch_size=32

性能对比实测

| 指标 | 传统自建集群 | Cloud AI Pass | 提升幅度 |

|---|---|---|---|

| 推理延迟 | 210ms | 168ms | 20%↓ |

| 部署周期 | 14天 | 2小时 | 98%↓ |

| 峰值承载量 | 1,200QPS | 3,600QPS | 200%↑ |

| 单位token成本 | $0.00037 | $0.00022 | 40%↓ |

测试环境:Llama 3-70B模型,1,000并发请求

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...