一、产品介绍:NIST的AI安全新里程碑

美国国家标准与技术研究院(NIST)作为全球权威技术标准制定机构,于2025年3月正式发布对抗性机器学习技术指南(NIST AI 100-2e2025)。新标准首次将87项攻击场景纳入联邦AI系统采购强制测试清单,覆盖数据投毒、隐私泄露、模型篡改等高风险漏洞,标志着美国政府从政策层面全面推动AI系统安全防护升级。布鲁金斯学会评价其为“AI安全治理的分水岭事件”。

二、谁必须关注这项新规?

- 联邦机构与技术承包商:所有向美国政府提供AI系统的企业需通过测试方可投标

- 金融/医疗等强监管行业:新规将成行业合规基准(如FDA医疗AI审批)

- AI开发团队与安全工程师:需重构开发流程满足鲁棒性要求

- 第三方审计机构:新增AI系统安全认证服务需求激增

三、核心功能与技术实现原理

| 功能模块 | 技术实现原理 | 应对攻击场景示例 |

|---|---|---|

| 多模态攻击检测 | 跨文本/图像/音频的对抗样本动态分析 | 规避攻击(如篡改自动驾驶车道识别) |

| 供应链安全防护 | 模型成分分析(SCA)+ 数据集完整性验证 | 第三方数据投毒、预训练模型后门植入 |

| 实时提示防御系统 | 指令注入检测引擎 + RLHF强化学习 | 直接提示注入(诱导生成有害内容) |

| 隐私泄露防护 | 差分隐私算法 + 查询访问控制 | 成员推断攻击(窃取训练数据分布) |

| 动态鲁棒性验证 | 对抗训练数据增强 + 形式化验证 | 模型提取攻击(复制商业模型架构) |

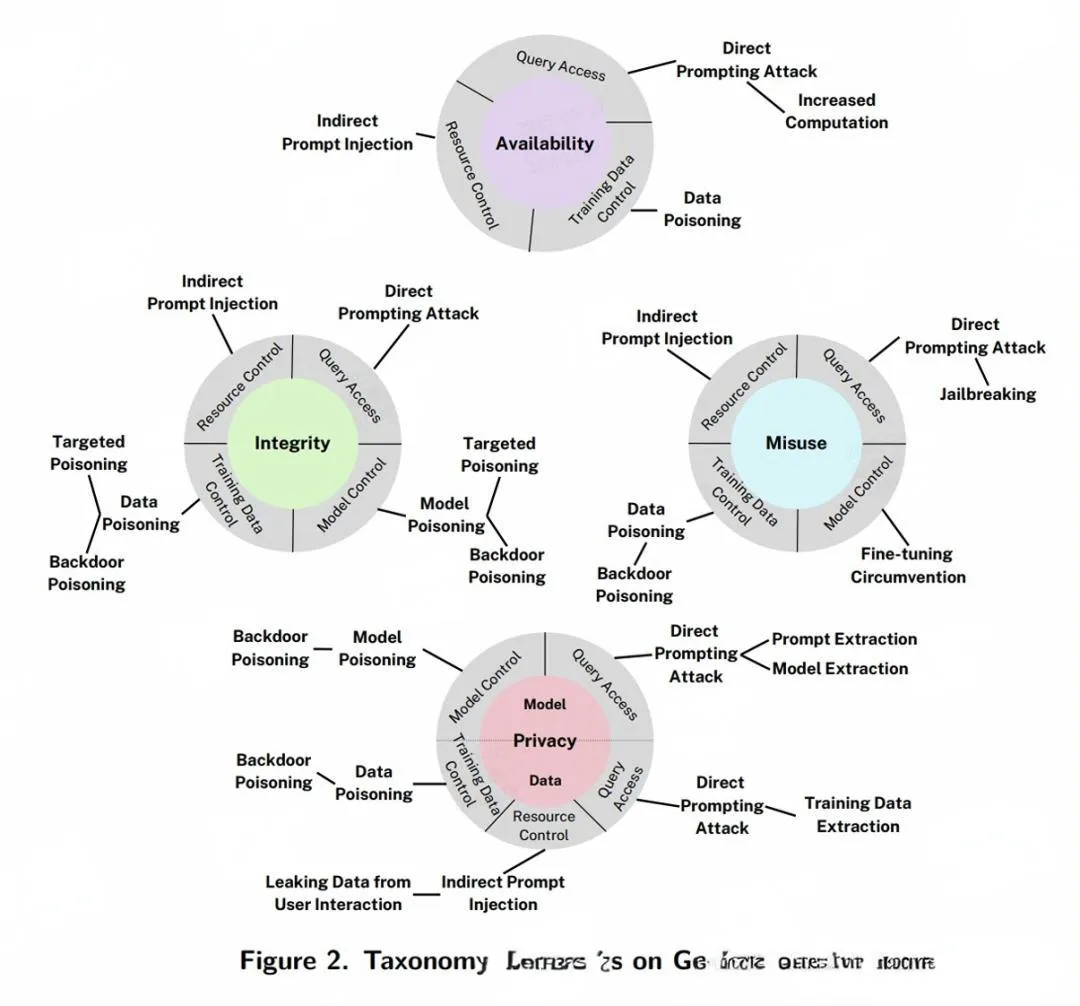

不仅如此,新框架更创新性地提出四大防护维度:

- 可用性防护:阻断服务瘫痪型攻击(如模型资源耗尽)

- 完整性防护:防止输出篡改(如生成虚假新闻)

- 隐私防护:敏感数据泄露防护(如患者病历逆向工程)

- 滥用阻断:禁用恶意内容生成(如钓鱼邮件自动生产)

四、实战技巧:快速通过87项测试的3大策略

▶ 红队演练模板(直接用于合规测试)

# NIST建议的对抗样本自动化测试流程

from nist_aml_toolkit import AdversarialBenchmark

benchmark = AdversarialBenchmark(scenario=87)

test_report = benchmark.run(

model=your_ai_model,

attack_types=["data_poisoning", "prompt_injection", "model_extraction"]

)

print(f"合规分数: {test_report.compliance_score}") ▶ 数据投毒防护黄金法则

训练数据三重过滤:

- 静态清洗:移除非常规字符组合(如隐藏指令代码)

- 动态分析:检测标签异常分布(标签翻转攻击标识)

- 来源追溯:区块链验证数据集哈希值

推理阶段实时防护:

流程图

用户输入 → 恶意指令检测器 → 安全:正常输出

↓

阻断 → 记录攻击指纹 → 更新防御模型

▶ 生成式AI专项加固方案

针对ChatGPT等大模型系统,务必配置:

- 系统提示符加密:防止“越狱”指令破解

- 输出内容水印:追踪恶意内容来源

- 上下文长度监控:阻断超长注入攻击(>2000 tokens需触发审核)

五、立即行动:获取完整资源

? 官方文档下载:

? 合规时间表:

- 2025年10月:联邦采购系统接入测试平台

- 2026年1月:首批强制认证生效

技术注释:现有系统可通过NIST的迁移指南(MLSec-2025)分阶段改造,重点优先处理高风险场景(标记为Critical的23项攻击)。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...