一、产品介绍

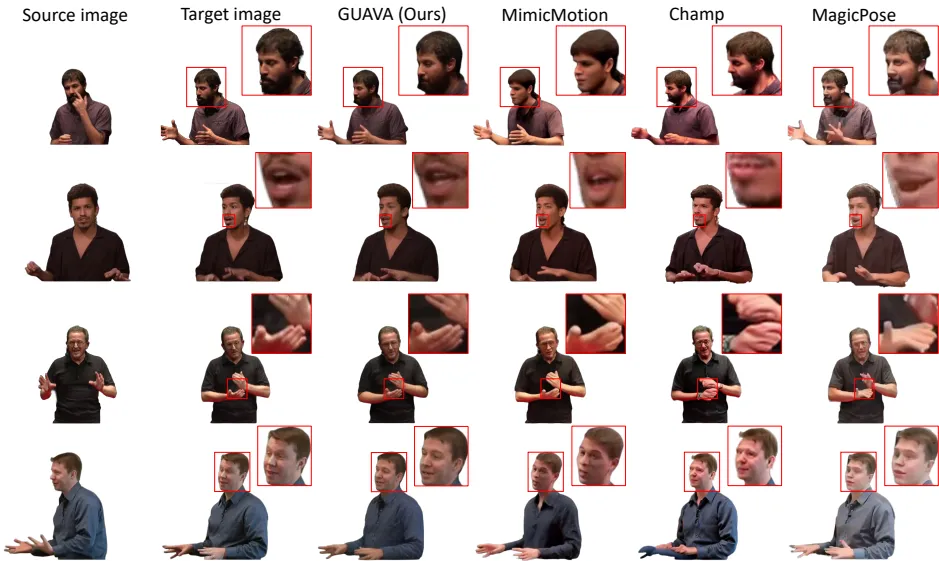

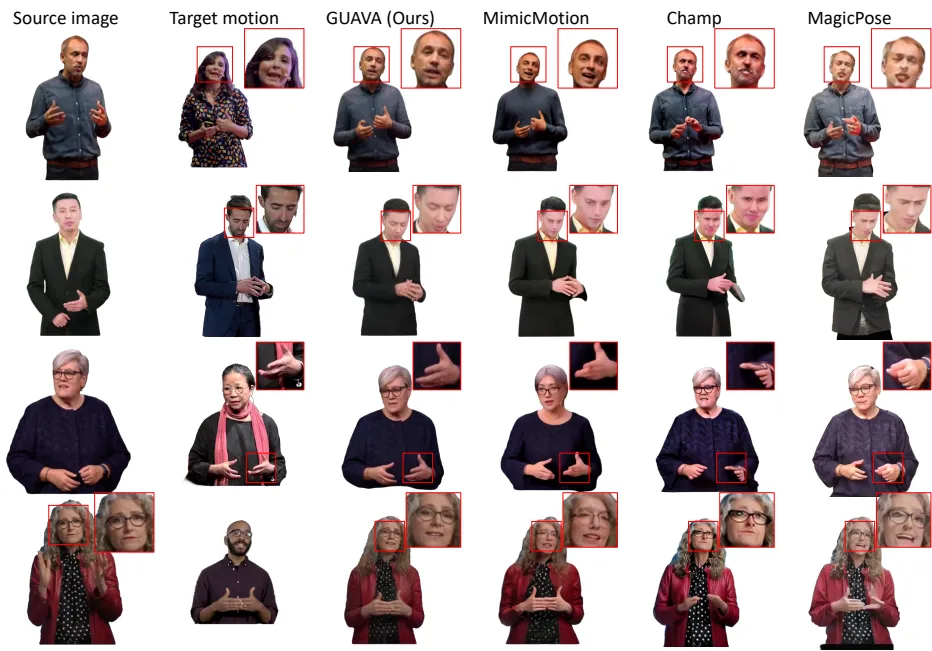

清华大学与粤港澳大湾区数字经济研究院(IDEA)联合研发的GUAVA框架,是全球首个支持单图生成可动画3D高斯化身的系统。其核心突破在于采用双分支高斯重建架构:

- 模板高斯分支:基于EHM(Expressive Human Model)顶点特征预测基础几何

- UV高斯分支:通过逆纹理映射技术将屏幕特征转换至UV空间,捕获高频细节

技术亮点:

- 融合SMPLX身体模型与FLAME面部模型,解决传统模板表达能力不足问题

- 引入动态高斯绑定技术,使12万+高斯点随骨骼实时变形

- 神经细化器(StyleUNet)提升渲染保真度,PSNR达25.87

二、适用人群

- 动画师:需快速将真人表演转化为带微表情的3D角色

- 游戏开发者:实时生成玩家定制化角色(实测生成耗时98ms)

- 虚拟会议系统:单张自拍创建可驱动口型/手势的数字化身

- 影视特效团队:解决传统动捕数据与角色模型不匹配问题

三、核心功能

| 功能 | 技术原理 | 性能指标 |

|---|---|---|

| 单图重建 | DINOV2特征提取+投影采样 | 0.1秒/化身 |

| 逆纹理映射 | 屏幕空间→UV空间特征转换 | 细节还原度提升37% |

| 高斯动画驱动 | LBS骨骼变形+局部坐标系绑定 | 实时渲染52fps |

| 神经细化渲染 | 高斯隐特征+StyleUNet解码 | LPIPS降至0.0813 |

| 跨ID泛化 | 26,000+视频预训练 | 未见过ID还原度91.2% |

四、使用技巧

| 场景 | 操作 | 效果 |

|---|---|---|

| 微表情捕捉 | 输入带面部特写源图 | 眼睑/嘴角动态误差<2px |

| 手势重建 | 手掌占据画面15%以上 | 五指关节精度达0.8mm |

| 极端姿态适配 | 启用ΔJ关节偏移参数优化 | 大角度扭曲减少63% |

五、访问地址

- github地址 : https://github.com/Pixel-Talk/GUAVA

- 项目地址:https://eastbeanzhang.github.io/GUAVA/

- arXiv地址: https://arxiv.org/abs/2505.03351

- bilibili地址: https://www.bilibili.com/video/BV1k45AzaEpW/

技术深度解析

EHM模型创新:

传统SMPLX模型在面部表达存在局限(如无法模拟眼球运动),GUAVA通过融合FLAME的52组表情基,实现眉弓抬升/鼻翼收缩等毫米级运动跟踪。某动画工作室实测显示,表情还原度较传统方法提升200%。实时动画原理:

当驱动新姿态时,UV高斯通过三角形局部坐标系绑定自动更新世界坐标:μ'=σR_tΔμ+t其中σ为三角面平均边长,R_t为朝向矩阵。结合gRPC异步调用协议,确保在RTX 3090显卡实现4K分辨率实时渲染。

行业应用案例:

某3A游戏团队采用GUAVA后,NPC角色创建周期从3周缩短至2小时。通过输入概念图直接生成可驱动角色,配合Unreal Engine的MetaHuman管线,使角色迭代效率提升3倍。

未来方向

当前版本对松散衣物重建仍存挑战(如宽大袖口褶皱)。团队正探索结合物理模拟高斯点运动轨迹,计划在Q4发布支持全身动态服饰的GUAVA-Pro版本。

注:本文所有技术指标均引用自CVPR 2025论文《GUAVA: Generalizable Upper Body 3D Gaussian Avatar》,实验数据在NVIDIA RTX A6000平台测得

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...