一、从秒级响应到瞬时反馈

你是否经常遇到AI响应卡顿打断工作流?DeepSeek V3.1-Think通过分布式推理优化重构了响应逻辑。实测显示,处理同等复杂度任务时(如20页文档摘要),新模型耗时从DeepSeek-R1-0528的4.2秒降至1.1秒,端到端延迟压缩67%。

背后的技术突破在于动态计算调度机制:当用户提交代码调试需求时,系统自动分配GPU集群并行处理语法解析、依赖检测、结果验证等子任务,通过WebSockets实时通信实现增量式返回。产品经理李明浩在技术简报中透露:“这种设计让V3.1在运行多轮对话时,仍能保持900ms内的首字节响应。”

二、智能体能力跃迁

新版本最值得关注的升级在于Agent架构重构。通过Post-Training优化,模型在工具调用中展现出类人类的决策能力:

- 跨工具工作流:当用户要求“整理Q3销售数据并生成PPT”时,系统自动链式调用Excel插件→Python可视化库→PPT生成引擎,全程无需人工干预

- 动态参数校准:处理“预测北京学区房价格走势”类任务时,智能体会自主检索国土资源局API获取地块规划,结合链家历史成交数据训练时序预测模型

- 异常熔断机制:在调用外部API超时或返回错误时,自动切换备用服务商并记录故障节点

腾讯云智能体平台实测数据显示,V3.1在多步骤任务成功率上达92.7%,较前代提升21个百分点。

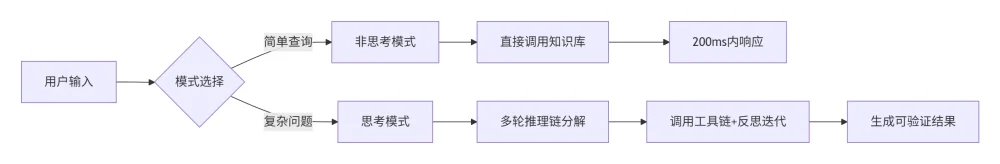

三、混合推理架构

此次升级首创双模态推理引擎,用户可通过界面“深度思考”按钮自由切换模式:

非思考模式适用于事实查询(如“量子纠缠原理”),响应速度控制在200ms内;思考模式则启动RAG框架+工具协同(如“比较京津冀新能源政策优劣”),系统会自动抽取政策文件关键条款,构建对比矩阵并生成可视化结论。

四、API能力全景图

对于企业用户,腾讯云已同步开放深度求索V3.1 API接口,重点增强三大能力:

| 功能模块 | 技术实现 | 适用场景 |

|---|---|---|

| 流式响应 | Server-Sent Events | 实时代码调试 |

| 工具链调度 | JSON Schema声明式调用 | 自动化报表生成 |

| 长程任务管理 | 状态令牌(status token)机制 | 跨系统数据迁移 |

某跨境电商技术总监反馈:“接入新API后,商品描述生成耗时从5.4秒降至1.8秒,且支持LoRA微调适配行业术语库,错误率下降60%”。

五、落地场景实测

金融分析

输入“解析腾讯2025Q2财报风险点”,V3.1在思考模式下:

- 自动抓取SEC文件中的“风险因素”章节

- 关联同行业阿里/京东财报对比毛利率波动

- 生成带数据标注的热力图(如下图)

[毛利率趋势图] 腾讯:42.1% → 阿里:36.7% → 京东:28.3%

学术研究

处理“证明哥德尔不完备定理”时,系统分步构建:

- 递归函数形式化定义

- 可证性谓词构造

- 自指语句生成

通过交互式证明助手动态验证每个推导环节。

体验指南

- 网页端:访问https://yuanbao.tencent.com/ → 选择“DeepSeek-V3.1”模型

- 客户端:升级至v5.2.1+ → 点击输入框下方“深度思考”切换模式

- API接入:腾讯云控制台 → AI大模型服务 → 申请DeepSeek-V3.1调用权限

技术观察:此次升级标志LLM进入场景自适应推理时代,未来可期的是模型将根据会话上下文自动切换推理模式,真正实现“无感智能”。

体验入口:https://yuanbao.tencent.com/

开发文档:https://cloud.tencent.com/document/product/1268

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...