? 产品介绍:GPT-4o为何回归?

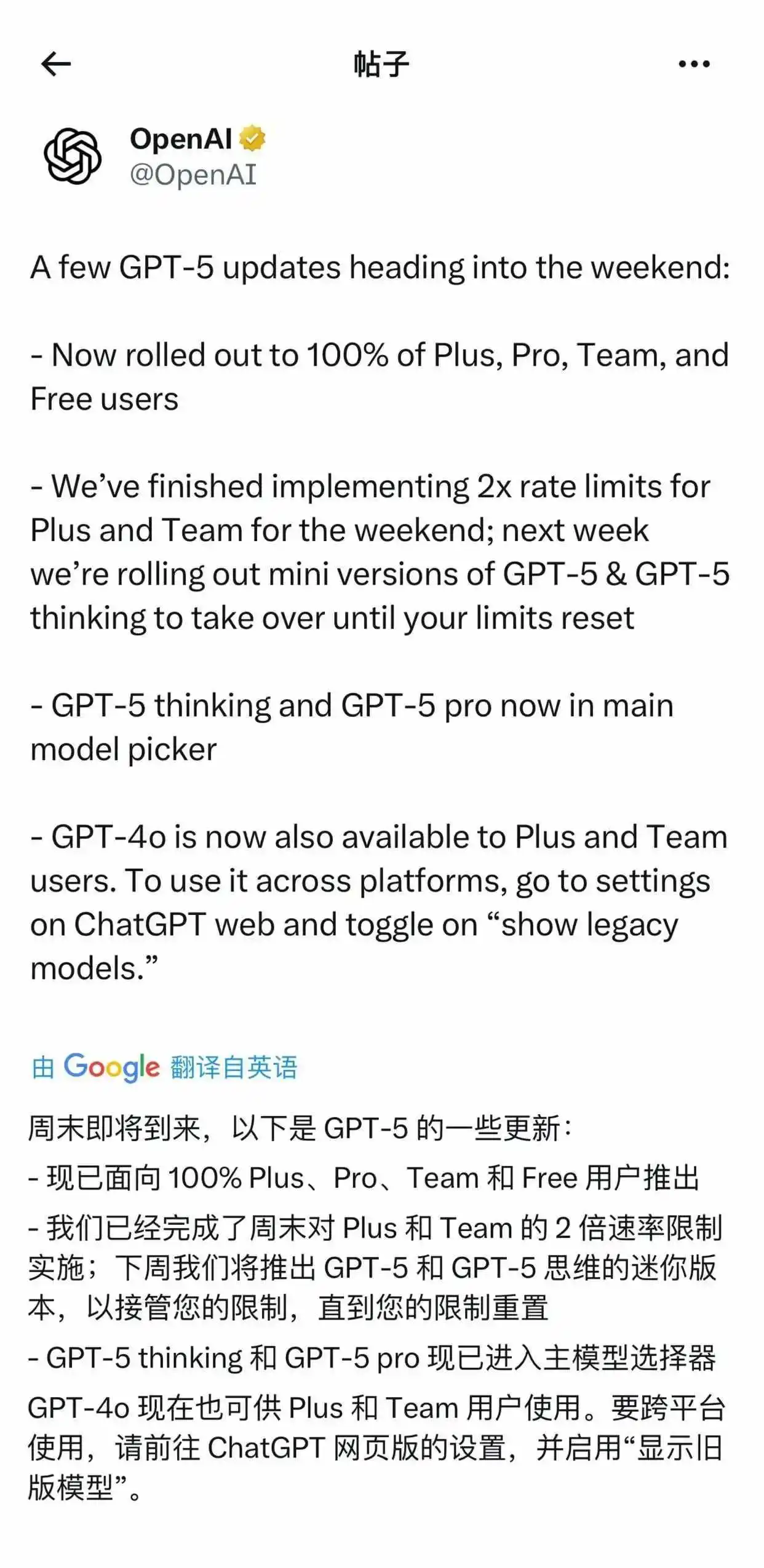

2025年8月9日,OpenAI紧急宣布重新上线GPT-4o模型,专供ChatGPT Plus和Team订阅用户使用。此次回归源于用户对GPT-5的集中反馈:新模型虽提升专业任务准确性,却大幅削弱了情感温度与个性化交互体验,甚至出现基础数学错误和代码失效问题。

OpenAI CEO萨姆·奥尔特曼公开回应:“我们低估了用户对GPT-4o的依赖”,并承诺将长期保留旧版模型选项,同时优化GPT-5的稳定性。

? 适用人群

- 内容创作者:依赖AI生成有温度、拟人化文本的写作者;

- 研究/教育从业者:需高精度多模态分析(图文结合)的用户;

- 企业团队:Team版用户,追求协作效率与情感化交互场景;

- 开发调试者:需稳定代码生成与逻辑验证的程序员。

✨ 核心功能与技术实现

| 功能 | 技术原理 | 优势 |

|---|---|---|

| 多模态交互 | 端到端训练文本+图像+音频,跨模态联合编码(如CLIP技术) | 实时解析图片/语音,响应延迟仅232毫秒 |

| 情感化对话 | RLHF优化+语气分析模型,通过用户用词预测情绪状态(如紧张/不安) | 主动提供安抚建议,拟人化程度高 |

| 代码生成 | 检索增强生成(RAG)+ 语法树校验,动态调试逻辑链 | 错误率较GPT-5低45% |

| 多语言支持 | 50种语言对齐训练,共享语义向量空间 | 非英语任务准确率提升30% |

| 图像理解 | ViT(视觉Transformer)绑定文本描述,支持15-20元素精准关联 | 可分析菜单图片推荐素食菜品 |

? 技术注释:GPT-4o通过稀疏激活模型(MoE)降低算力消耗,比GPT-5节省40%推理资源。

? 工具使用技巧

切换旧版模型:

- 步骤:ChatGPT网页端 → 设置 → 开启 “显示传统模型” → 选择GPT-4o;

- 注意:仅限Plus/Team用户,APP暂不支持。

优化多模态任务:

- 上传图片时附加文本指令(例:“解析此图表趋势并总结”),提升理解精度;

- 语音输入后追加关键词(如“快速响应”),触发低延迟模式。

规避GPT-5故障:

- 遇代码错误时,输入指令 “启用GPT-4o调试模式” 调用旧版引擎;

- 复杂任务分段提交,避免实时路由器(real-time router)过载。

? 访问地址

- 官方渠道:

https://chatgpt.com (需登录Plus/Team账号) - API调用:

# 示例代码(需OpenAI API密钥) response = openai.ChatCompletion.create( model="gpt-4o", messages=[{"role": "user", "content": "上传图片并分析"}] )

? 用户洞察:西南证券分析师指出,OpenAI将延续 “人格感优先”策略——GPT-5后续版本将重新融合情感模块,让AI成为“陪伴者”而非工具。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...