一、破局者登场:FuriosaAI的硬核突围

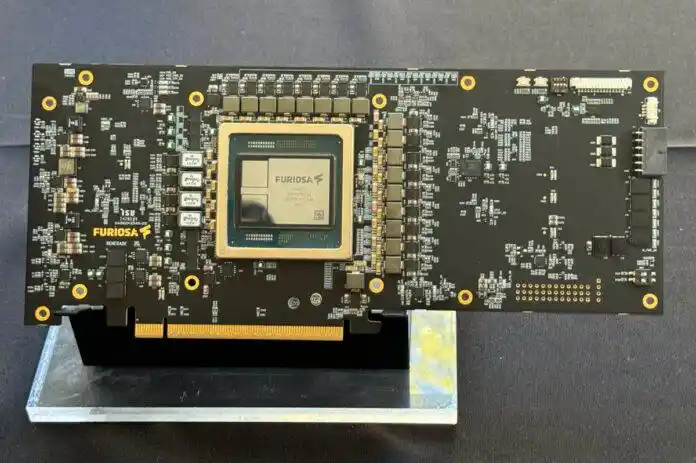

韩国AI芯片创企FuriosaAI在拒绝Meta 8亿美元收购后仅四个月,正式宣布与LG AI Research达成战略合作。其自主研发的RNGD芯片(发音同“Renegade”)历经七个月性能与能效验证,将成为LG下一代大语言模型Exaone 4.0的推理算力引擎。这一合作标志着韩国本土AI产业链完成“芯片-模型-应用”闭环,挑战英伟达全球垄断格局。

核心驱动力:

- ⚡️ 能效革命:在LG实测中,RNGD运行Exaone模型的推理性能达竞品GPU的2.25倍,功耗仅180W

- ? 本土化替代:LG选择RNGD降低对英伟达依赖,硬件成本直降40%,总拥有成本(TCO)显著优化

- ? 架构革新:采用张量收缩处理器(TCP)架构,通过减少矩阵乘法指令数量,实现计算效率跃升

二、适用人群:谁需要关注这项技术?

| 目标用户 | 核心价值 |

|---|---|

| 企业IT决策者 | 替代高成本GPU,降低AI服务器运维成本 |

| AI模型开发者 | 获取针对大模型优化的推理加速环境,缩短部署周期 |

| 边缘计算厂商 | 兼容低功耗场景,支持金融/医疗等隐私敏感领域本地化部署 |

| 韩国本土生态 | 构建从芯片(Furiosa)、模型(Exaone)到应用(ChatExaone)的自主技术链条 |

三、RNGD芯片的五大硬核能力解析

推理性能倍增

- 技术实现:原生AI架构设计,放弃图形渲染与挖矿功能,专注Transformer模型算子优化

- 实测表现:在Exaone 32B模型上,首Token延迟(TTFT)控制在0.3秒(3000 Token提示),吞吐量达50-60 Token/秒

超低功耗设计

- 创新点:台积电5nm工艺 + CoWoS-S 2.5D封装,HBM3内存功耗比GDDR降低35%

- 能效比:1.4 teraFLOPS/瓦,接近英伟达Hopper架构水平

多卡并行扩展

- 部署方案:支持PCIe 5.0张量并行,单服务器搭载8张加速卡,总带宽6TB/s

- 编译器优化:通过通信调度重叠技术,缓解多卡互联瓶颈

即插即用集成

- 软件栈:预装vLLM推理运行时,兼容PyTorch/TensorFlow框架,无缝对接Exaone

- 部署案例:沙特阿美、LG已用于企业内部AI代理ChatExaone

长上下文支持

- 内存配置:48GB HBM3显存,满足Exaone 4.0的32K上下文处理需求

四、企业部署实战技巧

▶︎ 硬件选型建议

| 配置类型 | 适用场景 | 推荐方案 |

|---|---|---|

| 轻量推理节点 | 文档摘要/客服机器人 | 2卡RNGD集群 + Exaone 7.8B模型 |

| 高性能计算中心 | 科研模拟/金融预测 | 8卡RNGD服务器 + Exaone 32B |

| 边缘设备 | 工业质检/医疗影像 | 单卡定制化 + Exaone 1.2B |

▶︎ 调优关键步骤

- 精度压缩:将FP16模型降至FP8,吞吐量翻倍提升(需激活Exaone量化工具链)

- 批处理优化:批量64请求时性能仅衰减20-30%,建议动态批处理设置

- 冷却方案:180W TDP适配风冷机柜,无需液冷改造

五、生态合作与获取路径

- 技术接入:通过LG AI Research获取Exaone+RNGD整合方案,含预训练模型授权

- 试用申请:美国/中东/东南亚企业可联系FuriosaAI硅谷办公室(官网提交需求)

- 开发者支持:开源推理工具包WarBoy SDK已在GitHub发布

? 访问地址:https://www.furiosa.ai | https://huggingface.co/LGAI-EXAONE

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...