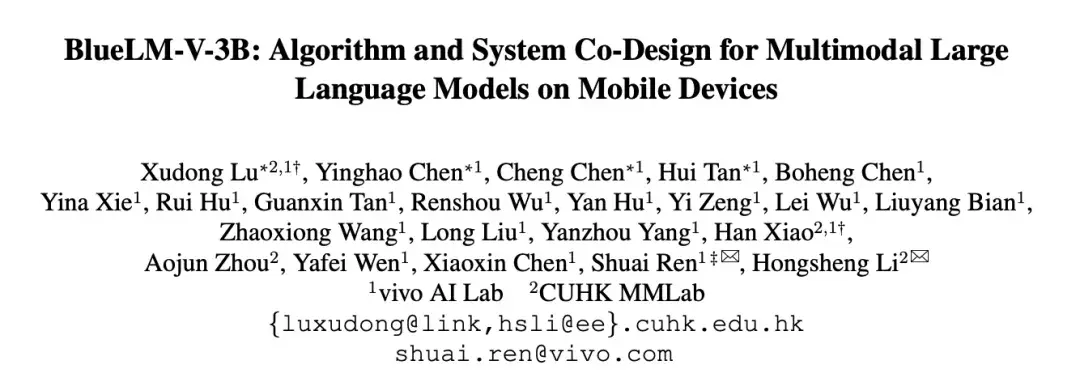

? 产品介绍

vivo AI Lab 于2025年7月推出新一代端侧多模态模型——BlueLM-2.5-3B。作为专为移动设备优化的AI引擎,它以仅2.9B参数(比同类模型小22%!)实现文本推理+图像理解+GUI交互三重能力融合。尤其突破性支持手机界面动态解析,让AI真正“看懂”你的屏幕!

? 适用人群

- ▸ 移动开发者:快速集成GUI自动化测试功能

- ▸ 效率工具党:实现截图转指令、图文交互助手

- ▸ 产品经理:探索端侧AI创新交互场景

- ▸ AI研究者:学习紧凑模型的多模态训练方案

? 核心功能与技术实现

| 功能模块 | 技术原理 | 性能优势 |

|---|---|---|

| GUI动态解析 | ViT视觉编码器+AnyRes方案,支持1512×1512分辨率子图并行处理 | ScreenSpot中文评测领先竞品15%+ |

| 思考预算控制 | Token预算分配机制动态切换长短思考模式 | AIME25任务推理得分提升40% |

| 多模态联合推理 | 四阶段训练:文本预训练→图文联合训练→推理增强→长文优化 | MathVista多模态任务超Gemma3-4B |

| 超轻量部署 | 大模型裁剪蒸馏技术,3T tokens压缩训练降低22%参数量 | 端侧推理能耗降低30% |

| 中文场景优化 | 百万级中文APP截屏数据训练,适配本土UI逻辑 | ScreenSpot vivo中文评测榜首 |

✨ 深度技术解析

动态思考引擎

独创Thinking Token Budget机制,像“智能档”般自动分配计算资源:- 短思考模式:即时响应基础问答(如“截图中按钮在哪?”)

- 长思考模式:激活深层推理链(如“从报表图分析销售趋势”)

> 在MathVision任务中,长思考模式提升精度达19.2分!

防遗忘训练架构

采用推理能力后置技术,将STEM/编程等高阶训练置于多模态阶段后期,避免传统多模态模型的文本能力退化。结果?文本任务媲美纯文本模型Qwen3-4B,多模态任务碾压同级!能耗控制黑科技

- ViT视觉编码器仅占400M参数

- 子图切片并行计算,功耗随token量线性增长而非指数级

> 同等任务下,能耗仅为Qwen2.5-VL-3B的78%

?️ 工具使用技巧

截图秒分析

上传APP截图时添加指令:“解析屏幕元素:可点击按钮+导航栏位置+核心功能入口”

→ 自动生成界面交互地图论文党必备

开启长思考模式处理图表:“请分析图3中的实验数据趋势,总结不超过3点结论”

→ 输出带数据支撑的精准解读开发调试助手

输入错误日志+界面截图:“根据报错信息和当前UI状态,定位可能故障点”

→ 给出代码层+界面层的关联分析

? 访问地址

▸ 模型下载:vivo AI Lab官网-BlueLM专区

▸ Demo体验:vivo开发者平台-在线测试

(支持上传截图/GIF/PDF实时测试GUI解析能力!)

技术革新不是堆参数,而是让每一比特都发光✨

BlueLM-2.5-3B用3B的躯体跑出10B级大脑——

这,才是端侧AI该有的样子!?

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...