一、革命性产品诞生:当法国极客遇见语音未来

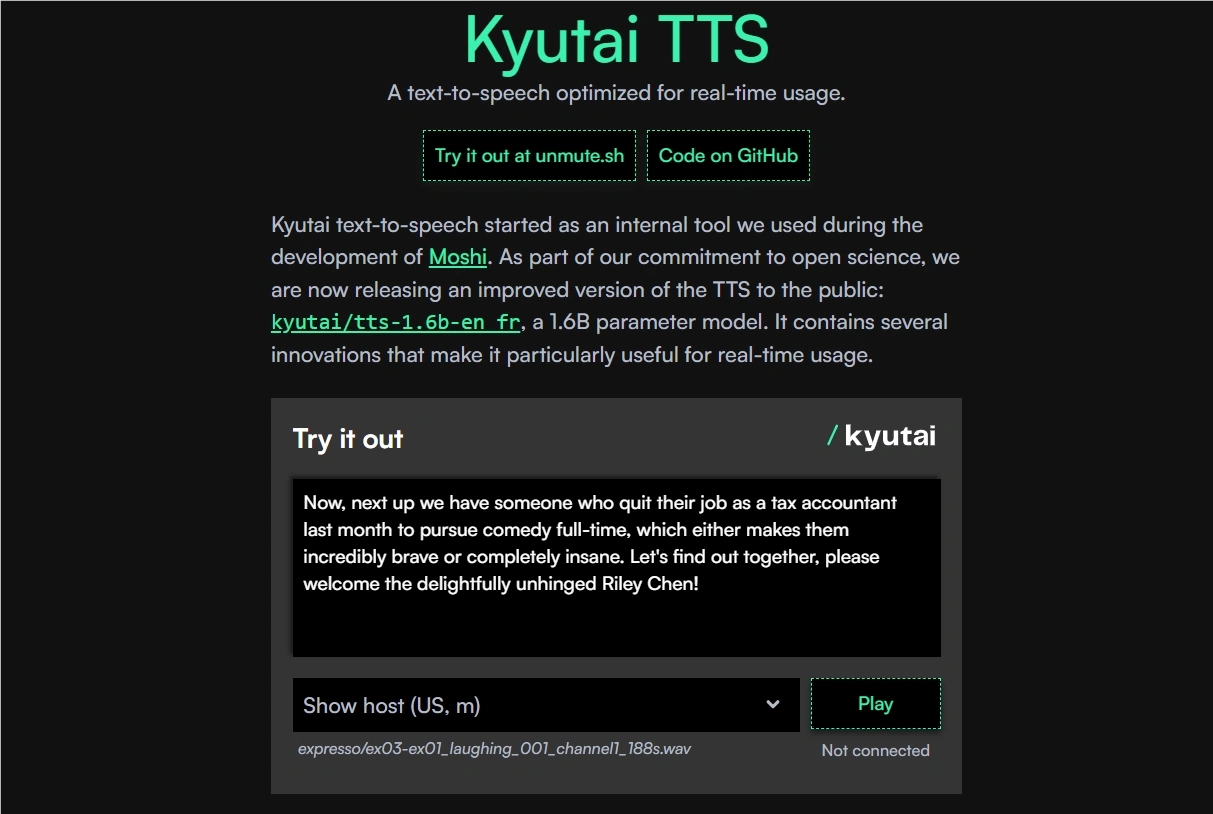

法国AI实验室Kyutai Labs(由科技巨头Xavier Niel资助)近期开源了颠覆性语音引擎Kyutai TTS。不同于传统语音合成工具,它采用独创的延迟流建模框架(DSM),将文本流与语音流并行处理,实现边接收文字边生成音频的实时交互体验。

核心突破在于:

- ⚡ 350ms响应:单块L40S GPU支持32路并发

- ? 词错误率<3%:英语2.82%/法语3.29%

- ? 声纹克隆:10秒样本复刻真人音色

实验室负责人公开表示:“我们要让机器语音摆脱机械感,实现人类级的自然对话流”

二、谁该立刻尝试这款神器?

| 适用人群 | 典型场景 | 收益对比 |

|---|---|---|

| 开发者 | 虚拟人/智能客服 | 降低300%延迟成本 |

| 内容创作者 | 有声书/播客制作 | 生成效率提升5倍 |

| 视障辅助机构 | 实时文本朗读 | 相似度达78.7% |

| 跨国企业 | 多语言语音系统 | 支持英法双语无缝切换 |

三、五大核心技术解剖

1. 流式文本处理引擎

技术原理:采用动态分块机制,将输入文本拆解为50ms级微批次。通过双缓冲并行处理架构,当前批次生成音频时,下一批次已完成特征提取,消除传统TTS的等待延迟。

graph LR

A[文本流输入] --> B{动态分块}

B --> C[批次1特征提取]

B --> D[批次2特征提取]

C --> E[批次1音频生成]

D --> F[批次2音频生成]

E --> G[实时输出]

F --> G2. 延迟流建模(DSM)

通过引入时间偏移对齐算法,让语音生成比文本处理延迟3-5帧。这种设计既保证音素准确性,又实现音频流连续输出,彻底告别卡顿。

3. 多模态融合编码

# 伪代码展示语音/文本特征融合

def encode(audio, text):

audio_features = CNN_Encoder(audio)

text_features = Transformer_Encoder(text)

# 跨模态注意力融合

fused_features = CrossAttention(audio_features, text_features)

return fused_features采用卷积-Transformer混合编码器,在音素边界注入时间戳标记,实现单词级时间戳精度±20ms。

4. 长上下文处理

突破性采用分段注意力机制,将长文本切分为逻辑段落。每个段落独立生成后,通过声学过渡网络平滑连接,消除传统30秒长度限制。

5. 设备端优化方案

特别开发MLX苹果芯片版本,支持:

- 4-bit量化压缩技术

- 核心推理引擎<100MB

- iPhone实时生成(需ios17+)

四、高手都在用的调参秘籍

延迟优化技巧

python tts_mlx.py --quantize 4 --chunk_size 32启用4-bit量化+32帧分块,iPhone延迟降低40%

声纹克隆实战

准备10秒干净人声样本,运行:python voice_clone.py -i sample.wav -o custom_voice长文处理必看

添加--paragraph_pause 200参数,在段落间插入200ms自然停顿

五、立即体验未来语音

? 官方三重访问通道:

在线体验

Kyutai TTS Demo生产环境部署

cargo install --features cuda moshi-server moshi-server worker --config configs/config-tts.toml苹果设备本地运行

pip install moshi-mlx echo "Bonjour!" | python tts_mlx.py - - --quantize 8

? 小贴士:运行时报错

CUDA out of memory?试试添加--max_memory 0.5参数限制显存用量

最后唠叨一句:在巴黎实验室的咖啡香气中诞生的Kyutai TTS,正重新定义人机语音交互的边界。当技术遇上艺术,机器终于学会像人类一样呼吸着说话。要不要试试看,让法式浪漫流淌在你的代码里?✨

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...