产品介绍

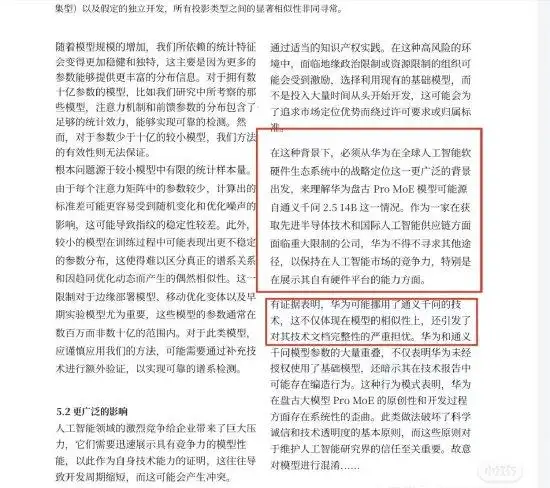

华为盘古大模型由华为云基于昇腾AI芯片研发,主打千亿级参数NLP与多模态能力,聚焦政务、工业等高精度场景。阿里通义千问(Qwen系列)是阿里巴巴开源的混合专家模型(MoE),支持119种语言,以低显存占用和高效Agent能力见长。两模型均属国产大模型第一梯队,却在2025年7月因参数结构相似性陷入争议漩涡。

适用人群

- AI开发者:需对比架构差异优化模型调参

- 企业技术决策者:评估大模型合规风险与部署成本

- 研究机构:关注AI知识产权边界与技术复用伦理

- 投资者:分析AI赛道竞争格局

核心功能与技术实现

| 功能 | 华为盘古Pro MoE | 阿里通义Qwen3 |

|---|---|---|

| 架构设计 | MoGE分组专家路由(昇腾原生优化) | 动态MoE+混合推理模式 |

| 参数量 | 总720亿/激活160亿 | 总2350亿/激活220亿 |

| 硬件适配 | 昇腾310/800I芯片深度优化 | 支持4张H20 GPU部署满血版 |

| 推理加速 | FlashComm通信优化,时延降22% | MNN引擎INT8量化(精度损失<1%) |

| 多模态支持 | 需配合CV扩展模块 | 端到端文本/图像/音频处理 |

关键技术解析

负载均衡机制

盘古采用MoGE架构,通过专家分组约束设备间计算负载,解决传统MoE专家闲置问题,昇腾芯片吞吐达1528 tokens/s;Qwen3则依赖动态路由算法,按输入动态激活专家,显存占用仅为同类1/3。推理优化技术

华为OptiQuant方案实现INT8与FP8精度持平,结合投机推理框架FusionSpec降低延迟;阿里使用MNN引擎融合算子,支持119语种跨语言检索。混合推理模式

Qwen3首创快慢思考集成:快模式秒级响应简单查询,慢模式深度处理科学计算;盘古Embedded 7B借鉴类似设计,在AIME测试超Qwen3-8B。工具调用能力

阿里原生支持MCP协议,封装API调用模板简化Agent开发;华为依赖昇腾算子库(如MulAttention融合)提升工具执行效率。

工具使用技巧

1. 降低推理延迟

- 盘古:启用

FlashComm3多流并行技术,AllReduce通信优化提升吞吐 - Qwen:调用

Qwen-Agent解析器,自动匹配快/慢思考模式节约算力

2. 成本控制

- 盘古部署需搭配GaussDB,建议国企选用(合规优势)

- Qwen3支持Ollama本地部署,4张H20 GPU即可运行235B模型

3. 精度优化

- 敏感任务(如金融风控)禁用量化,优先FP16精度

- 使用阿里

DataWorks脱敏数据训练,避免隐私风险

访问地址

争议仍在技术讨论阶段,法律对AI参数保护尚无定论。开发者复用开源组件时,务必审查许可证范围(如Qwen采用Apache 2.0),避免合规隐患。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...