一、顶尖人才流动背后的战略博弈

2025年8月下旬的硅谷,一场围绕AI顶尖人才的争夺战出现戏剧性转折:就在Meta宣布冻结人工智能部门普通岗位招聘的同时,苹果云基础设施及搜索技术负责人Frank Chu悄然加盟Meta超级智能实验室(MSL)。这已是第六位从苹果跳槽至Meta的AI核心成员,此前苹果模型团队创始人庞若明(Ruoming Pang)携四名工程师集体转投Meta,后者甚至开出了2亿美元的天价薪酬包。

Frank Chu的履历揭示了Meta的精准布局。他在苹果期间不仅主导云服务器上的大模型推理部署,更深度参与Siri搜索架构优化和娱乐服务的数据训练,其领导的团队直接为苹果基础模型(AFM)提供预训练所需的核心数据资源。这种既懂基础设施又精通产品落地的复合能力,恰是Meta推进“超级智能”计划急需的拼图。

技术迁移点:分布式训练集群的动态调度、LLM推理延迟优化、多模态搜索架构——这些Chu在苹果验证过的技术模块,将直接注入Meta的MSL Infra团队。

二、Meta的AI重组

表面看,Meta的招聘冻结决策与高薪挖角存在矛盾。内部备忘录显示,除“业务关键岗位”外,所有MSL团队招聘暂停,目的是“审慎规划2026年员工增长”。但若结合其半年内的四次重组动作,深层逻辑逐渐清晰:

架构洗牌

AI部门被拆分为四个垂直单元:- TBD实验室(超级智能攻关)

- Products and Applied Research(产品落地)

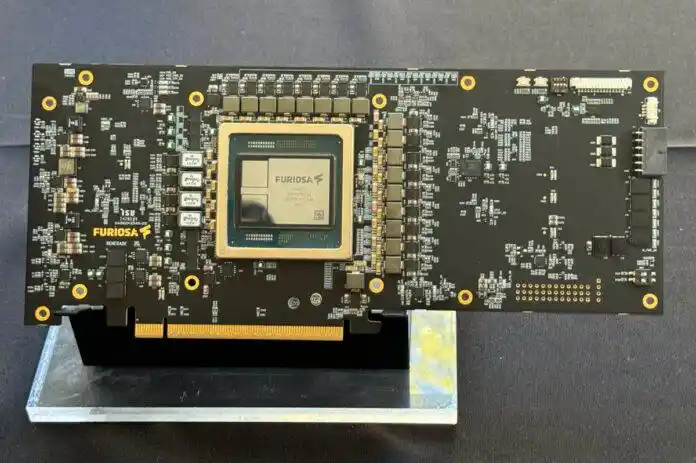

- MSL Infra(基础设施)

- FAIR(前瞻性研究)

新架构由前Scale AI CEO Alexandr Wang统一指挥,而Chu加入的正是负责算力基座的MSL Infra。

人才消化期

过去三个月Meta已招募超50名顶尖AI人才,包括20名OpenAI研究员、13名谷歌工程师及苹果核心成员。当团队规模激增时,整合资源比继续扩张更重要。发言人Andy Stone直言冻结期是为建立“稳定架构”——这就像分布式系统扩容后必需的协调期。算力押注替代人力增长

就在冻结招聘同日,Meta与谷歌云签署六年100亿美元合约,创下谷歌云史上最大订单。这笔交易将快速填补自建数据中心(如路易斯安那州400万平方英尺项目)的建设空窗期,为研究员提供即时可用的高性能算力。

基础设施升级:通过混合云策略(自建IDC+谷歌云弹性节点),Meta试图实现训练集群的异构资源池化,解决万卡级GPU集群的通信瓶颈。

三、苹果的AI困局

当Meta积极补强时,苹果的AI战略正遭遇严峻挑战。据内部人士透露,高层对自研基础模型的犹豫已导致团队士气溃散:

- 路线摇摆:考虑采用第三方模型(谷歌Gemini/Anthropic Claude)替代自研技术驱动Siri,使AFM团队存在价值受质疑

- 薪酬差距:Meta开出的薪资可达苹果的3倍以上,即便苹果紧急加薪仍难以抗衡

- 关键岗位真空:Chu离职前是苹果AI基础设施主管Benoit Dupin的副手,负责公有云LLM部署和预训练管线,其职能涉及Siri、Safari、Apple Music等核心产品的技术底座

更严峻的是,技术骨干的持续流失可能引发“断代风险”。庞若明团队的原班人马几乎被Meta整体挖走,而新成立的超级智能实验室(MSL)凭借清晰的AGI路线图,正持续吸引追求技术突破的研究者。

四、Meta的百亿算力网络

扎克伯格“千亿美元级AI投入”的承诺正在具象化。除人才招募外,Meta的基础设施投资呈现三重加速:

资本开支飙升

2025年资本支出预算从年初640-720亿美元上调至660-720亿美元,较2024年增长68%。其中大部分流向英伟达芯片采购和云服务合约,目标将算力密度提升3倍。混合云战略落地

与谷歌云的百亿合作打破传统绑定模式。Meta首次同时接入AWS、Azure、谷歌云三大服务商,通过智能流量调度实现:- 高峰时段调用谷歌云TPU v5集群

- 常规训练任务分配至自建数据中心

- 突发需求由Azure/AWS弹性节点承接

这种多云架构可降低30%的推理延迟。

软硬件协同优化

Chu的加入将强化基础设施与算法团队的协作。其在苹果验证过的技术——如Token动态压缩、异构硬件感知调度——有望提升Llama模型训练效率。此前Meta因Llama 3表现未达预期解散了AGI Foundations团队,新团队亟需在Llama 4实现突破。

五、AI竞赛进入算力效率时代

Frank Chu的跳槽不仅是人才流动案例,更揭示了AI竞争规则的演变:

从堆人力到拼架构

MIT研究报告指出,95%企业尚未从AI项目获得回报。当技术红利期消退,优化MIPS/Watt(每瓦特算力效能)比盲目扩大团队更重要。Meta冻结招聘却加码基础设施,标志竞争进入效率优先阶段。云服务市场重构

谷歌云凭借Meta订单跃升为AI算力关键玩家,其差异化优势在于TPU与LLM的深度适配。而AWS面临增长放缓压力,可能加速推进定制芯片[Nitro芯片矩阵升级];Azure则强化OpenAI生态绑定,三大云厂商的竞争焦点转向“AI效能即服务”。开放模型的生死时速

Meta开源策略面临新考验。要支撑Llama系列与闭源模型竞争,需在6个月内实现:- 千亿参数模型训练成本降低40%

- 推理响应延迟压缩至200ms内

- 多模态搜索精度提升至商业应用阈值

这恰是Chu团队的核心攻坚方向。

硅谷人才流向的隐喻:当苹果工程师批量流向Meta的超级智能实验室,当扎克伯格用百亿合约换取谷歌云的算力弹药库,我们正见证AGI竞赛从单点突破转向系统级对抗。Meta的MSL Infra能否将Frank Chu的搜索技术沉淀转化为AGI基础设施的护城河?2026年的Llama 4或是第一个检验坐标。

? 探索混合云架构实践:https://cloud.google.com/vertex-ai

? 开发者提示:关注LoRA微调适配、分布式推理框架(如vLLM)、Token动态压缩协议——这些Chu主导过的技术模块正成为AI基建新标准。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...