? 产品介绍

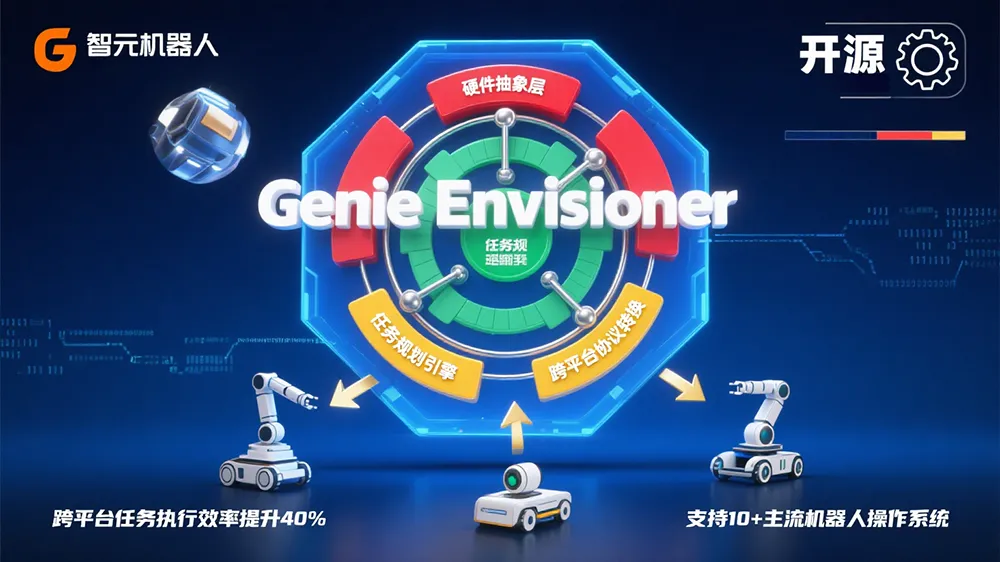

智元机器人(Agibot)作为浦东具身智能代表企业,于2025年8月14日正式推出行业首个动作驱动的开源世界模型平台——Genie Envisioner(GE)。不同于传统割裂的开发流程,GE创新性地将未来帧预测、策略学习与仿真评估整合进视频生成闭环架构,让机器人在单一模型中完成环境感知→决策推理→动作执行的全链条响应。

平台最大亮点在于:

✅ 开源承诺:完整代码、预训练模型、评测工具全面开放

✅ 真机验证:已实现倒茶、擦桌、做三明治等生活场景任务

✅ 效率革命:跨平台迁移仅需1小时数据(约250次演示)

? 适用人群

| 用户类型 | 核心价值场景 |

|---|---|

| 工业机器人开发者 | 快速适配产线新设备,减少重新训练成本 |

| 服务机器人团队 | 提升复杂长时序任务(如厨房操作)成功率 |

| 具身智能研究者 | 获取视觉世界模型开源代码与训练框架 |

| 教育机器人机构 | 低成本构建多机器人统一控制平台 |

⚙️ 核心功能(5大突破性能力)

跨本体秒级迁移

技术原理:基于视觉空间预训练的通用操控表征(非语言抽象),捕捉跨平台共享的物理规律。

效果:在Agilex Cobot Magic等新平台,仅用1小时演示数据实现高质量任务执行,性能超π0、GR00T等模型。10+步骤长时序执行

技术原理:通过Sparse Memory模块选择性保留历史关键帧,显式建模时序演化关系。

效果:折叠纸盒任务成功率76%(竞品π0仅48%)。多视角环境感知

技术原理:GE-Base模型同步处理头部+双腕三路视角,保持空间一致性。

效果:精准解析复杂环境布局与动作意图,避免单视角盲区。实时动作生成

技术原理:GE-Act采用异步推理模式(视频DIT 5Hz + 动作DIT 30Hz),慢-快双层优化。

效果:RTX 4090 GPU上200ms完成54步动作推理,满足实时控制需求。神经仿真验证

技术原理:GE-Sim通过层次化动作条件机制,将姿态投影为图像空间运动向量。

效果:提前预演动作后果,降低真实环境试错成本。

? 技术原理解剖

颠覆传统架构的视觉中心建模范式!

传统VLA方案需将视觉映射到语言空间(如“红色杯子在左边”),导致空间信息丢失。而GE直接在原始像素空间建模环境动态,保留完整时空结构。

技术栈三件套深度协同:

graph LR

A[GE-Base] -->|多视角视频流| B[GE-Act]

B -->|动作序列| C[GE-Sim]

C -->|预测帧反馈| A- GE-Base:3000小时真机视频训练,百万级数据炼成的世界模型“大脑”

- GE-Act:160M参数轻量解码器,视觉特征→控制指令的关键转化器

- GE-Sim:动作条件神经仿真器,通过Pose2Image机制预判动作结果

?️ 工具使用技巧(开发者必看)

快速迁移指南:

1️⃣ 在新机器人录制250+条演示视频(5Hz采样)

2️⃣ 加载GE-Base预训练权重冻结视觉编码器

3️⃣ 仅微调GE-Act动作层参数

? 实测效果:双Franka机械臂搬运任务适配时间<4小时长任务优化秘诀:

启用sparse_memory_ratio=0.3参数,让模型自动筛选30%关键历史帧,避免无关信息干扰。

? 访问地址

? 即刻获取开源资源:

▸ GitHub代码库:https://github.com/agibottech/genie-envisioner

▸ 项目主页:https://genie-envisioner.github.io

▸ 技术白皮书:https://arxiv.org/abs/2508.05635

最后划重点:

这不是又一个“实验室玩具”,而是经3000小时真机验证的生产力工具!无论是机械臂秒学新技能,还是攻克10步折叠纸盒难题,GE都用视觉直控的方案撕开了传统机器人学习的天花板。

注:平台完整支持ROS 2和Isaac Sim仿真环境,工业场景无缝集成。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...