? 产品速览

OpenAI 于2025年8月6日震撼发布两款开放权重模型 GPT-oss-120b 和 GPT-oss-20b,CEO Sam Altman称其为“世界最佳开放模型”。这两款模型采用Apache 2.0许可证,允许免费商用和定制开发,彻底打破企业级AI部署的成本壁垒。更令人惊喜的是,小模型20B版本仅需16GB内存即可运行,首次实现高性能大模型在手机、笔记本等边缘设备的落地!

? 适用人群

| 开发者类型 | 典型应用场景 |

|---|---|

| 个人开发者 | 本地AI助手开发、学习实验 |

| 中小企业技术团队 | 私有化部署企业知识库、客服系统 |

| 科研机构 | 安全领域微调、医疗研究 |

| 硬件厂商 | 预装设备端AI能力(如手机/PC) |

? 五大核心功能解析

1. 炸裂性能:闭源级推理能力

- 120B模型:1170亿参数MoE架构(激活参数仅51亿),在Codeforces编程测试中Elo评分2620+,媲美闭源o4-mini

- 20B模型:21亿参数支持16GB内存设备运行,在M3 Pro芯片上生成代码速度达23.72 token/秒

- 突破性表现:在医疗诊断基准HealthBench上超越GPT-4o,数学竞赛AIME准确率高达96.6%

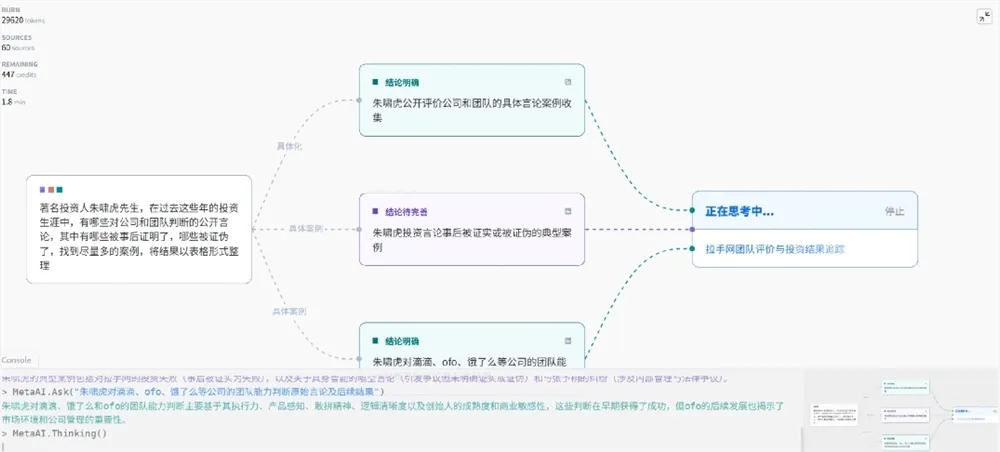

2. 原生AI Agent支持

- 内置函数调用(Function Calling)和工具执行引擎:

✅ 网页搜索 ✅ Python代码实时执行 ✅ 多轮工具链协作 - 独创Harmony对话格式:支持

<System> <Tool> <Developer>多角色指令,实现“思考→调用→总结”闭环

3. 动态推理强度调节

通过系统消息一键切换三种模式:

| 模式 | 适用场景 | 技术实现 |

|---|---|---|

low | 实时聊天(直接输出答案) | 跳过思维链,减少计算层数 |

medium | 代码调试(展示关键步骤) | 部分激活MoE专家模块 |

high | 数学证明(完整推导) | 全链CoT+128K上下文检索 |

4. 128K超长上下文

- 采用YaRN技术扩展上下文窗口,支持13万token长文档处理

- 搭配o200k_harmony分词器(与GPT-4o同源),提升多语言解析效率

5. 企业级安全架构

- 通过对抗性微调测试:在生物学/网络安全领域设置非拒绝版本防护墙

- 预训练过滤CBRN(化学/生物/核能)危险数据,符合企业合规要求

?️ 开发者必看技巧

▶️ 本地部署实战

# 使用Hugging Face快速调用(需24GB显存)

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("openai/gpt-oss-20b", device_map="auto")- 设备适配方案:

? Mac用户:通过Ollama部署Apple Silicon优化版

? Windows用户:安装ONNX Runtime GPU版加速推理

? 手机端:安卓使用MLC LLM,iOS适配CoreML

▶️ 低成本微调方案

1. **数据准备**:使用Harmony格式标注工具调用指令

2. **参数冻结**:仅微调路由层+1.2%专家模块(显存降低67%)

3. **部署验证**:通过τ-Bench测试Agent任务闭环率? 立即访问

- 模型下载:

https://huggingface.co/openai/gpt-oss-120b

https://huggingface.co/openai/gpt-oss-20b - 部署工具链:

? Ollama本地引擎:https://ollama.ai/openai

? Harmony格式渲染器(Python/Rust版):GitHub@OpenAI

? 真香警告:20B模型已在M3 Max MacBook Pro实测运行《贪吃蛇》代码生成,延迟仅1.3秒!现在就在你的设备上试试看吧~

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...