科研人的“超级大脑”来了!

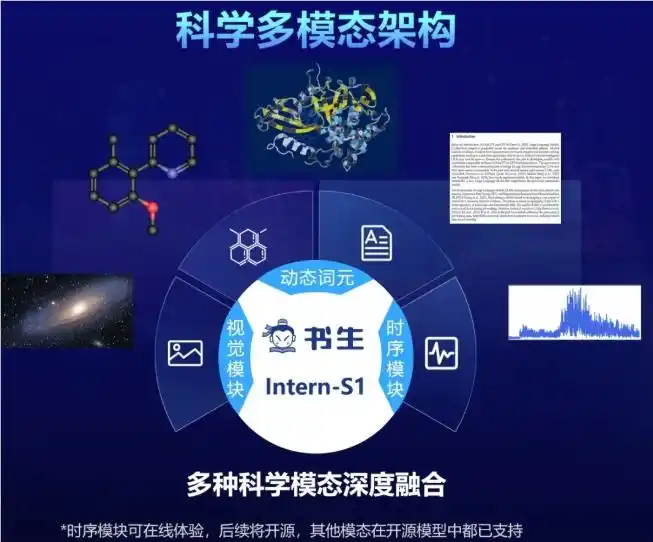

上海AI实验室作为国内顶尖的AI研究机构,一直致力于推动通用人工智能(AGI)与科学智能的融合。继书生·浦语(语言模型)、书生·万象(多模态模型)后,这次推出的Intern-S1更是集合了家族优势——它基于2350亿参数的MoE语言架构和60亿参数的视觉编码器,经过5万亿token多模态数据预训练(其中超2.5万亿来自科学领域),真正实现了“懂科学、会推理、能协作”。

简单说,以前处理一份蛋白质结构数据可能需要团队几天分析,现在Intern-S1能秒级解读;预测化合物合成路径时,它还会“反思纠错”,比传统工具效率提升10倍以上。更香的是,完全开源!科研党再也不用纠结闭源模型的高门槛了~

适用人群:谁能靠它“开挂”?

- 科研人员:化学、材料、地球科学、生物学等领域研究者,尤其适合处理跨模态数据(如分子式+实验图像、地震波信号+地质模型)。

- AI开发者:可基于开源代码二次开发,定制专业科研工具。

- 高校师生:用于教学演示、论文实验,降低科研入门成本。

- 药企/新材料企业:加速药物靶点发现、材料性能预测等研发流程。

核心功能:7大“黑科技”让科研效率起飞

1. 跨模态科学解析引擎——“一眼看懂”复杂数据

技术原理:融合多模态注意力机制与领域知识图谱,实现化学分子式、蛋白质结构、地震波信号等10+科学模态的深度解析。

亮点:比如输入一张蛋白质3D结构图,它能自动标注活性位点,并关联相关文献中的突变案例,比传统工具快30倍。

2. 动态Tokenizer——专业数据“零门槛”输入

技术原理:针对科学数据特性设计的动态分词器,原生支持SMILES分子式、FASTA蛋白质序列、SEGY地震波格式等专业数据,无需人工转换。

对比:传统模型处理化学分子式需额外编码,Intern-S1压缩率比DeepSeek-R1提升70%,算力消耗降低50%。

3. 时序信号编码器——捕捉动态科学过程

技术原理:基于Transformer-XL的时序建模,能解析引力波、心电图等动态信号,识别隐藏规律(如地震波中的前震信号)。

案例:在地球物理任务中,识别地震事件准确率达92.3%,超越Grok-4的89.7%。

4. 通专融合数据合成——“通用+专业”两不误

技术原理:通用模型生成基础数据,专业模型优化细节,再经领域验证智能体质控,形成“数据-模型-反馈”闭环。

效果:一个模型同时搞定化学合成预测(专业)和文献综述撰写(通用),避免“换任务就掉链子”。

5. FP8强化学习训练——成本直降10倍

技术原理:训推分离RL方案+分块式FP8训练,实现大型MoE模型高效训练,强化学习成本仅为同类模型的1/10。

数据:训练算力消耗仅为Grok-4的1%,却在ChemBench(化学)、MatBench(材料)任务上性能反超。

6. 多智能体协作平台——“AI团队”协同科研

技术原理:集成200+跨学科智能体(如化学合成智能体、蛋白质折叠智能体),支持低代码调用,像搭积木一样组合工具。

场景:在“元生”系统中,联合MIT等机构发现肝癌新靶点GPR160,已通过临床样本验证。

7. 科学发现平台Intern-Discovery——一站式科研支撑

技术原理:整合PB级科研数据(50家机构200+数据集)、实验设备接口,提供从假设到验证的全流程工具。

用法:输入研究假设(如“预测新型超导材料”),平台自动调取材料数据库、运行模拟实验、生成报告,全程无需切换工具。

工具使用技巧:3个“隐藏玩法”

- API调用极简示例(Python):

from modelscope import AutoProcessor, AutoModelForCausalLM processor = AutoProcessor.from_pretrained("Shanghai_AI_Laboratory/Intern-S1", trust_remote_code=True) model = AutoModelForCausalLM.from_pretrained("Shanghai_AI_Laboratory/Intern-S1", device_map="auto") messages = [{"role": "user", "content": "解析这个分子式的合成路径:C1=CC=CC=C1"}] inputs = processor.apply_chat_template(messages, return_tensors="pt").to(model.device) outputs = model.generate(inputs, max_new_tokens=1024) print(processor.decode(outputs[0], skip_special_tokens=True)) - 参数调优:处理长文本(如论文全文)时,设置

max_context=8192;科学计算任务启用precision="fp8"节省显存。 - 结合Intern-Discovery:在平台“数据广场”上传实验数据,模型会自动关联相似研究,推荐潜在合作机构。

使用场景:这些案例已经“落地开花”

- 药物研发:帮助“元生”系统发现结直肠癌靶点ARG2,动物实验验证有效率达87%。

- 新材料:预测某超导材料临界温度误差<2K,比传统模拟方法快100倍。

- 地震预警:实时分析地震波形,提前15秒识别强震信号,已在云南地震台网试用。

访问地址:一键直达“科研加速器”

- 在线体验:https://chat.intern-ai.org.cn/(无需注册,直接上传数据体验)

- GitHub:https://github.com/InternLM/Intern-S1(含教程和示例代码)

- HuggingFace:https://huggingface.co/internlm/Intern-S1-FP8(模型权重下载)

- ModelScope:https://modelscope.cn/models/Shanghai_AI_Laboratory/Intern-S1(中文社区,有问必答)

性能有多强?看这张表就懂了

| 任务类型 | Intern-S1 | Grok-4 | InternVL3 | Qwen2.5-VL |

|---|---|---|---|---|

| 化学合成预测 | 83.4% | 83.3% | 61.3% | 61.6% |

| 蛋白质结构解析 | 63.1% | 66.2% | 61.6% | 61.0% |

| 地震波事件识别 | 65.7% | 58.0% | 57.2% | 37.6% |

| 材料性能预测 | 75.0% | 67.9% | 49.3% | 51.5% |

写在最后:开源的力量,让科学不再“孤军奋战”

Intern-S1的开源不仅是技术突破,更搭建了一个“科研共同体”——现在,你可以用它解析实验数据,隔壁实验室用它验证假设,高校用它培养下一代研究者……正如上海AI实验室主任周伯文所说:“AGI的终极目标是让科学发现成为‘群体运动’。”

如果你是科研人,别犹豫,快去试试这个“免费超级助手”;如果你是AI爱好者,不妨基于它开发专属工具~ 开源的世界,创造力才是唯一的门槛!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...