一、开篇:一场改写AI算力规则的收购

2025年7月,英伟达悄然完成一项关键布局——以超4亿美元收购仅成立3年的多伦多AI公司CentML。这家由95后华人工程师王尚与导师Gennady Pekhimenko教授创立的初创企业,凭借独创的GPU优化技术,直击全球AI行业痛点:在芯片短缺时代,如何让现有硬件释放翻倍算力?

收购后,CentML核心团队全员入驻英伟达,创始人Pekhimenko出任AI软件高级总监,王尚则主导AI系统软件研发。尤为值得注意的是,CentML的Hidet编译器技术将整合至CUDA生态,为开发者提供“不换硬件也能倍增性能”的颠覆性工具。

二、适用人群:谁将从中受益?

- AI开发工程师:需优化大模型推理效率的团队

- 云计算服务商:寻求降低GPU运营成本的平台

- 边缘计算开发者:面向自动驾驶、IoT设备的低功耗场景

- 企业技术决策者:规划AI基础设施升级路径的CTO

三、核心功能:榨干每一块GPU的隐藏性能

CentML的核心价值在于通过软件层创新,破解硬件利用率不足的行业难题。以下是其五大技术突破:

| 功能 | 技术原理 | 实测效果 |

|---|---|---|

| Hidet张量编译器 | 动态分析模型算子结构,实现跨层融合计算,减少内存迁移 | Llama 2推理速度提升3倍 |

| 动态神经网络压缩 | 基于硬件特性的自适应精度调整,保持精度下减少计算量 | 能耗降低40% |

| Hexcute领域语言 | 为AWQ量化模型定制混合专家层融合内核 | DeepSeek-R1推理速度超Triton方案 |

| 水平融合训练阵列(HFTA) | 并行任务深度融合,单卡同步训练多模型 | GPU利用率提升15.1倍 |

| DeepView分析工具 | 实时监控训练瓶颈,预测部署成本 | 算力规划效率提升70% |

? 技术亮点解析:

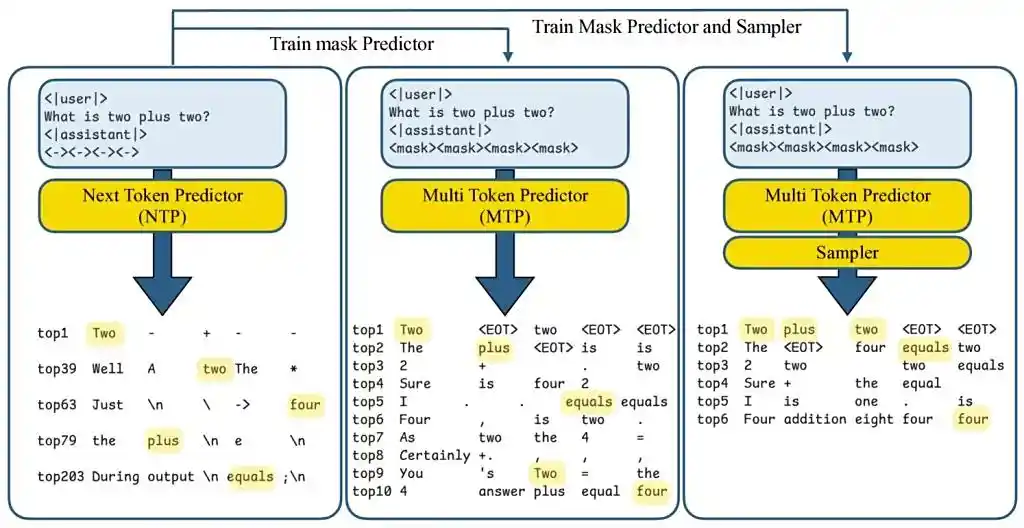

- Hidet编译器通过操作符融合技术,将多个模型算子合并为单一计算单元。例如在Llama 2推理中,它把Attention层的矩阵乘法和Softmax融合执行,避免中间结果反复读写内存,直接减少80%数据搬运开销。

- HFTA技术突破性地在同一GPU上并行训练超参数组合。传统方式需多卡独立运行,而HFTA将不同任务的算子横向融合,像“拼积木”般构建复合计算图,使单卡吞吐量提升15倍。

四、工具使用技巧:低成本实现高效部署

场景1:大模型推理加速

- 步骤:

- 使用Hidet加载PyTorch/ONNX模型

- 调用

auto_fusion()自动识别可融合算子 - 生成针对特定GPU架构的优化内核(支持NVIDIA/AMD/TPU)

- 案例:CentML为DeepSeek-R1的MoE层构建融合内核,比vLLM引擎提速22%

场景2:训练成本压缩

- 技巧:

- 用DeepView分析训练任务,定位资源浪费环节

- 采用HFTA合并相似训练任务(如超参调优)

- 启用动态压缩技术适配边缘设备

五、访问信息

- 官方入口:CentML服务已整合至英伟达AI Enterprise Suite(访问链接)

- 开源工具:Hidet编译器代码库(GitHub链接)

- 技术文档:英伟达CUDA 2025Q3更新将包含集成文档

行业影响:这场收购不仅是技术整合,更标志着AI竞争进入“软硬协同”新阶段。当AMD收购Untether AI、英伟达连收Lepton AI和CentML,芯片巨头正全力争夺“每瓦算力效率”的制高点。对开发者而言,无需天价囤积H100,用软件优化释放存量设备潜力,才是未来三年的生存法则。

注:CentML独立服务已于2025年7月17日停止运营,其技术全面融入英伟达AI软件栈。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...