一、产品介绍

昆仑万维作为中国AI领域的创新力量,于2025年7月4日推出第二代开源奖励模型 Skywork-Reward-V2 系列。该系列包含8个基于Qwen3和LLaMA3架构的模型,参数规模横跨6亿至80亿,首次在RewardBench v1/v2、PPE Preference & Correctness等七大权威评测榜单实现全维度领先。其突破性在于:以1/45参数量超越前代性能(如0.6B模型媲美上代27B模型),重新定义小模型的潜力边界。

二、适用人群

- ? AI研究员:需高效RLHF训练工具

- ?️ 开发者:构建安全对齐的大语言应用

- ? 企业技术团队:低成本部署高性能奖励系统

- ? 教育/科研机构:复现前沿对齐技术

三、核心功能与技术解析

| 功能 | 技术实现原理 | 性能表现 |

|---|---|---|

| 人类偏好对齐 | 基于4000万对偏好数据(Skywork-SynPref-40M)训练,融合人类标注与AI扩展两阶段优化 | RewardBench v1得分97.8 |

| 抗风格偏差 | 动态对抗训练框架,分离内容质量与风格特征 | RM-Bench SOTA |

| Best-of-N扩展 | 多响应并行评分机制,支持N选1最优策略 | PPE Correctness子项全榜首 |

| 安全合规控制 | 嵌入多维度安全准则,实时检测有害输出 | JudgeBench安全评分83.4 |

| 跨任务泛化 | 混合数据集覆盖知识密集型/主观决策场景,提升迁移能力 | 7大评测平均分88.6 |

? 技术突破点:

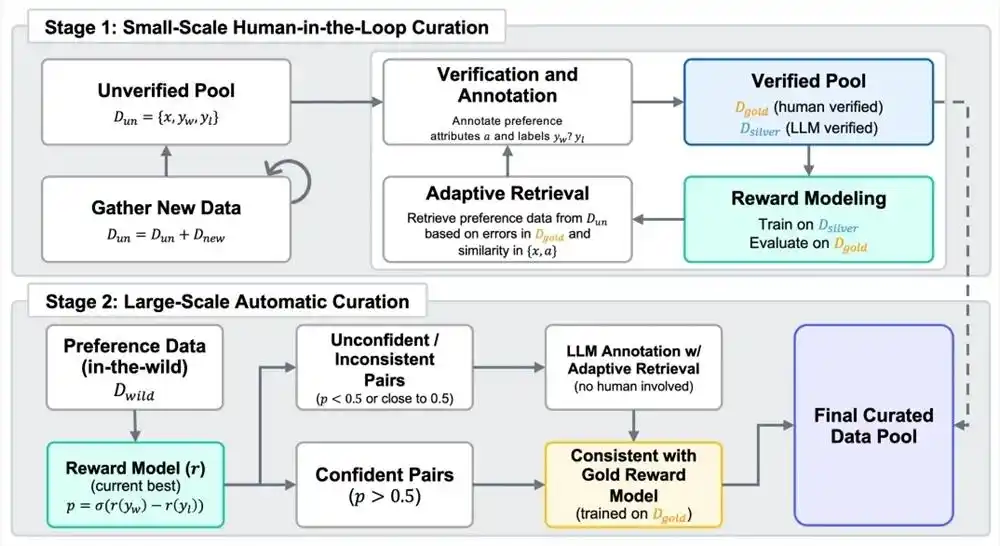

独创人机协同数据过滤流程:

- 第一阶段:人工标注"金标准"数据 → LLM生成"银标准"数据 → 多轮迭代优化

- 第二阶段:奖励模型自动一致性过滤 → 平衡规模与质量(2600万高质量样本)

此设计解决传统偏好数据的过拟合问题,让小模型实现参数效率飞跃。

四、工具使用技巧

轻量化部署

- 优先选择

Skywork-Reward-V2-Qwen3-1.7B:1.7B参数即超越70B级开源模型,适合边缘设备

- 优先选择

复杂任务优化

- 调用

Skywork-Reward-V2-Llama-3.1-8B处理知识密集型任务(如医疗/金融决策),结合其客观正确性优势

- 调用

数据迭代加速

- 利用模型的自适应检索机制:动态筛选高价值样本,减少70%人工标注成本

规避风格偏见

- 启用

风格偏差抵抗模块:对创意文本生成场景尤为重要

- 启用

五、访问地址

- ? HuggingFace模型库:

https://huggingface.co/collections/skywork/skywork-reward-v2 - ? 技术报告:

https://arxiv.org/abs/2507.01352 - ⚙️ GitHub代码库:

https://github.com/skyworkai/skywork-reward-v2

最后想说,当技术不再被参数绑架,当小模型也能读懂人心——这或许就是AI对齐最美的样子 ?

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...