? 产品介绍

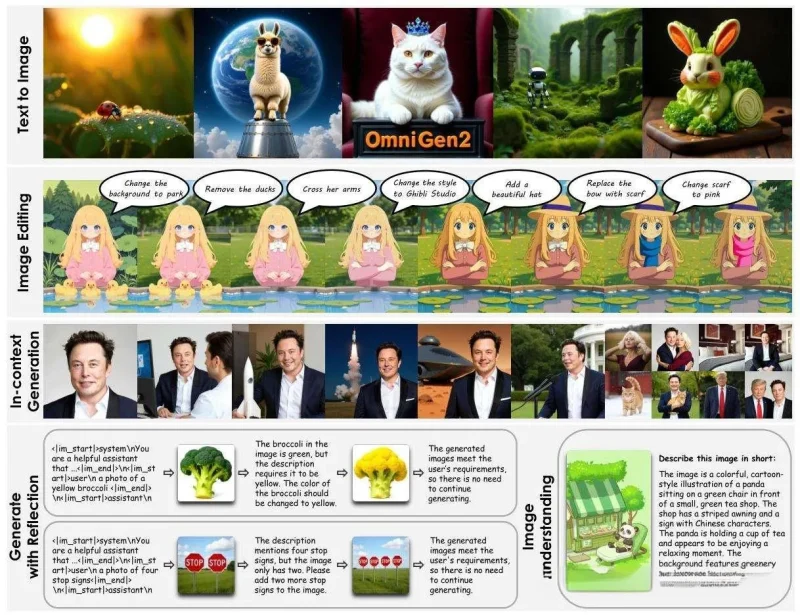

北京智源人工智能研究院(BAAI)2025年推出的OmniGen2,是新一代统一图像生成模型[]。作为前代OmniGen的升级版,它采用4B参数规模,在GitHub上线一周即斩获2000+星标,海外社交平台浏览量超数十万次[]。其核心突破在于:

- 任务统一性:单模型支持文生图/修图/主题生成等全场景

- 推理效率提升32%:通过TeaCache缓存加速策略优化

- 开源开放:模型权重/训练代码/数据集全面开源

? 适用人群

| 用户类型 | 典型场景举例 |

|---|---|

| ? 设计师 | 快速生成广告概念图/修改商品背景 |

| ? 内容创作者 | 角色场景融合/漫画分镜生成 |

| ? AI开发者 | 二次训练自定义图像生成模型 |

| ? 教育工作者 | 可视化教学素材实时生成 |

?️ 核心功能与技术解析

1. 自然语言指令编辑

功能:通过文字指令实现局部修改

技术原理:

采用分离式架构解耦文本与图像处理[],搭配ViT+VAE双编码器:

- ViT编码器解析语义指令(如“换蓝色裙子”)

- VAE编码器定位像素级编辑区域

- 扩散模型执行局部重绘并保留原图细节[]

案例:

“移除图片中的猫” → 精准删除目标且自动补全背景[]

2. 文生图任意比例生成

功能:支持1:1/2:1/3:2等非标准比例输出

技术原理:

基于Omni-RoPE三维位置编码[]:

- X轴标记序列位置

- Y/Z轴标记图像空间坐标

- 动态适应不同画幅构图需求

3. 多图元素融合(上下文生成)

功能:提取多图元素生成新场景

技术原理:

创新视频关键帧数据构建流程[]:

- 用Qwen-VL识别视频关键帧主体

- GroundingDINO标注边界框

- SAM2分割跟踪目标对象

- FLUX.1-Fill生成新背景

局限:物体相似度>人脸相似度[]

4. 图像生成反思机制

功能:自动检测缺陷并迭代优化

技术原理:

模仿LLM的自监督反思训练[]:

生成图像 → 分析缺陷 → 提出改进 → 重新生成缺陷分析覆盖:指令理解偏差/未满足要求/原图局限[]

5. 跨模态统一架构

技术突破:

- 文本路径:冻结Qwen2.5-VL-3B参数保持语言理解[]

- 图像路径:独立训练4B扩散模型提升视觉质量

- 控制信号:用

<|img|>标记触发图像生成[]

? 工具使用技巧

| 操作类型 | 正确指令示例 | 错误示例 |

|---|---|---|

| 局部修改 | “将红裙改为蓝色,保留褶皱纹理” | “换蓝色”(指令模糊) |

| 风格迁移 | “转换成宫崎骏动画风格” | “画成卡通” |

| 多图融合 | “把图A的猫放到图B的沙发上” | “合并A和B” |

| 参数优化 | text_guidance_scale=1.5 | >2.0导致过度艺术化 |

避坑指南:

- 人脸修改建议分步操作:先调整表情→再换背景

- 复杂指令用分号分隔步骤:“删除路人;调亮天空;添加樱花树”

- 输入图像分辨率>512×512避免细节丢失[]

? 访问地址

- 在线体验:智源科研平台

- 开源代码:GitHub仓库

- 模型下载:Hugging Face主页

实测彩蛋:输入“赛博朋克熊猫喝茶”生成效果惊艳度99%✨

OmniGen2的突破不仅在于技术——它将专业级图像创作的门槛降到了一句自然语言指令。更惊艳的是其开源诚意:从数据构造流程到反思机制完整公开,让开发者能基于此构建专属创作工具。实际操作中,建议优先尝试其多图融合功能,你会惊叹于AI对复杂语义的解析能力!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...